Мультимодальный ИИ — это системы, которые могут понимать и генерировать информацию из различных типов данных, включая текст, изображения, аудио и видео. В отличие от традиционных моделей искусственного интеллекта, которые работают с одной модальностью, мультимодальные модели предназначены для обработки и интеграции информации из нескольких источников одновременно.

Это обеспечивает более точные рассуждения, более эффективное взаимодействие и более широкое применение в реальных задачах.

От способности GPT-4 обрабатывать голосовой и визуальный ввод до приложений в медицинской диагностике, робототехнике и создании мультимедийных материалов — мультимодальный искусственный интеллект быстро становится центральным фактором восприятия окружающего мира и реагирования машин на него.

Понимание мультимодального искусственного интеллекта: определение и основы

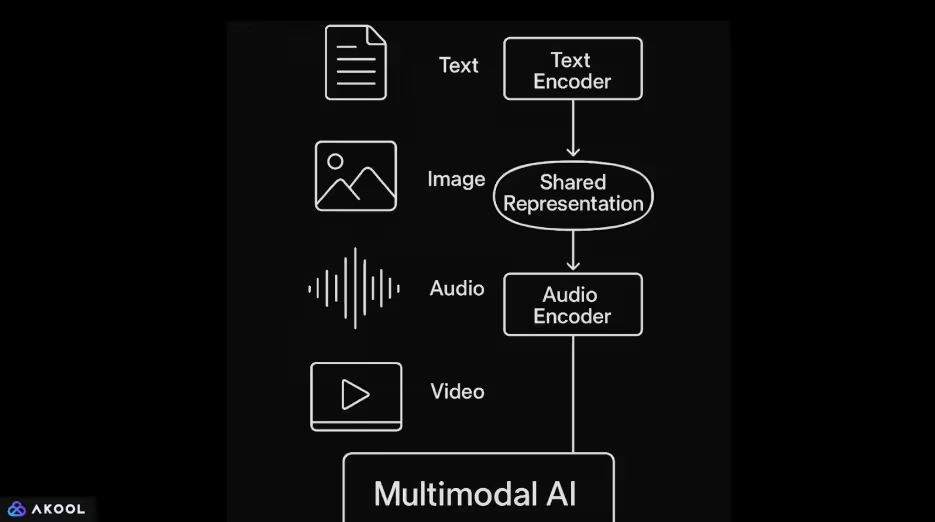

Мультимодальные системы искусственного интеллекта объединяют различные типы данных, такие как текст, изображения, аудио и видео, в одной модели. Каждый ввод сначала обрабатывает специальный кодер. Языковые модели на основе Transformer обычно обрабатывают текст. Изображения обрабатываются с помощью сверточных нейронных сетей или преобразователей зрения. Звук часто кодируется с помощью моделей на основе спектрограмм или преобразователей осциллограмм.

Как только каждый ввод закодирован в векторное представление, модель сопоставляет эти векторы в общее скрытое пространство.

Это общее пространство позволяет системе изучать взаимосвязи между различными модальностями. Например, оно может привязать заголовок к изображению или сопоставить произнесенную фразу с соответствующим видеоконтентом. Механизмы внимания часто используются для согласованного согласования и интеграции информации из этих входных данных.

Мультимодальный искусственный интеллект обеспечивает более гибкие и контекстно-зависимые результаты. Одна модель может выполнять такие задачи, как описание изображений на естественном языке, ответы на вопросы о видеоконтенте или генерирование ответов на основе комбинации текста и визуальных эффектов.

Узнайте больше о мультимодальные агенты искусственного интеллекта.

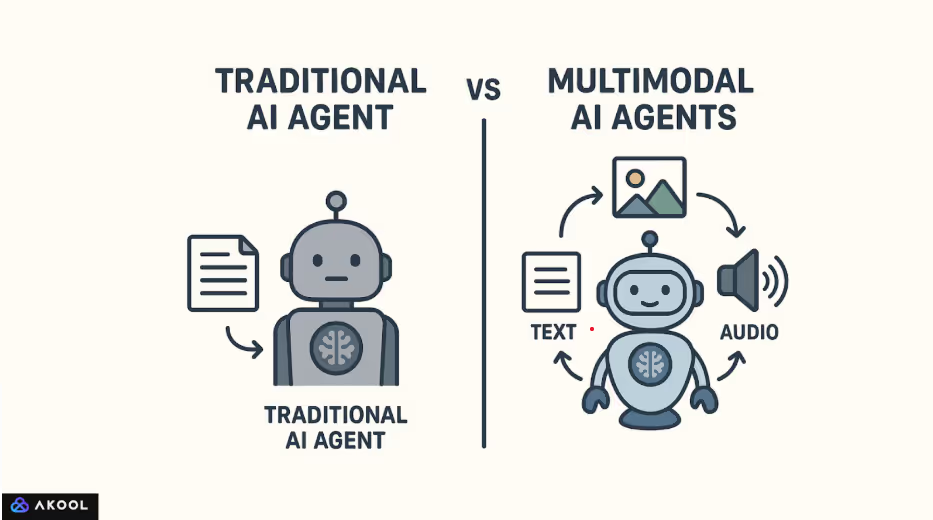

Чем мультимодальный ИИ отличается от традиционного

Основа мультимодального искусственного интеллекта была заложена ранними работами в области субтитров к изображениям и визуальных ответов на вопросы. Заметный прогресс начался с таких моделей, как Show and Tell (Google, 2015), в которых сверточные сети сочетались с рекуррентными языковыми моделями. Исследования, проведенные компаниями FAIR (Facebook AI Research) и OpenAI, способствовали дальнейшему развитию этой области, разработав архитектуры, в которых масштабное обучение проводилось на парных наборах данных из текста и изображений.

CLIP (предварительное обучение контрастивному языку и изображениям), выпущенный OpenAI в 2021 году, стал важным поворотным моментом. CLIP изучала визуальные концепции непосредственно под наблюдением за естественным языком, что позволило использовать их для решения широкого круга задач по классификации изображений без доработки.

За ними последовали DALL·E, Flamingo от DeepMind и совсем недавно GPT-4 с возможностями машинного зрения.

Эти разработки отражают переход от конвейеров, ориентированных на конкретные задачи, к моделям общего назначения, которые могут обрабатывать несколько типов входных данных в единой структуре.

Традиционные модели искусственного интеллекта обычно предназначены для обработки одного типа входных данных. Например, языковая модель, такая как GPT-2, обучается только на тексте, а сверточная нейронная сеть, такая как RESnet, оптимизирована для классификации изображений.

Эти модели работают в изолированных областях и не могут естественным образом интерпретировать или связывать информацию в разных модальностях.

Мультимодальный ИИ, напротив, создан для обработки и объединения нескольких типов данных в одной системе. Он не рассматривает текст, изображения или аудио как отдельные потоки, а кодирует их в единое репрезентативное пространство. Это общее пространство позволяет модели устанавливать связи между модальностями.

Например, оно может связать изображение с заголовком, сопоставить звук с визуальной сценой или ответить на разговорную речь сгенерированным видеокадром.

Как работает мультимодальный искусственный интеллект: технические компоненты

Мультимодальный искусственный интеллект позволяет единой системе обрабатывать, согласовывать и аргументировать различные типы входных данных, таких как текст, изображения, аудио и видео.

Вместо того чтобы рассматривать каждый тип данных по отдельности, оно создает общее понимание, преобразуя каждую модальность в форму, которую можно сравнивать, комбинировать и совместно использовать в последующих задачах.

1. Кодирование каждой модальности

Процесс начинается с кодирования необработанных входных данных в структурированные представления:

- Текст кодируется с использованием языковых моделей на основе преобразователей, учитывающих семантику и синтаксис.

- Изображения обрабатываются с помощью сверточных нейронных сетей или трансформаторов зрения для извлечения визуальных признаков.

- Аудио преобразуется в спектрограммы или обрабатывается непосредственно в виде осциллограмм с помощью специализированных кодеров, таких как Wav2Vec или AudioMae.

- Видео включает как пространственную, так и временную обработку, часто с использованием 3D-каналов CNN или механизмов внимания, учитывающих время.

Каждый кодировщик преобразует входные данные в вектор большой размерности, отражающий наиболее важные характеристики.

2. Сопоставление с общим пространством представлений

Закодированные векторы проецируются в общее скрытое пространство, где информация из разных модальностей становится сопоставимой. Это пространство обучено таким образом, чтобы семантически схожее содержимое, например изображение и его заголовок, располагались близко друг к другу. Такие модели, как CLIP, достигают этого с помощью метода сравнительного обучения, при котором совпадающие пары объединяются, а несовпадающие — друг от друга.

Это общее пространство является основным фактором, способствующим взаимопониманию между разными видами транспорта. Например, оно позволяет модели извлекать изображение на основе текстового запроса или генерировать текст на основе визуального ввода.

3. Кросс-модальное согласование и слияние

После кодирования информация из различных модальностей интегрируется через механизмы внимания и слои слияния. Здесь модель учится выравнивать соответствующие части каждой модальности, например, связывать слово в предложении с определенной областью изображения.

Стратегии слияния различаются в зависимости от архитектуры:

- Раннее слияние объединяет входные данные перед любой глубокой обработкой.

- Поздний синтез объединяет выходные данные после независимой обработки каждой модальности.

- Промежуточное (суставное) соединение является наиболее эффективным и широко используемым, обеспечивая богатое взаимодействие на нескольких уровнях модели.

4. Совместное мышление и получение результатов

Благодаря выровненным мультимодальным представлениям модель может выполнять задачи, требующие совместного понимания всех типов входных данных. Она может генерировать текстовое описание изображения, отвечать на вопросы о видео или вести устные диалоги, основанные на визуальном контексте.

Декодер или головка, предназначенная для решения конкретных задач, преобразуют объединенные представления в выходные данные. В генеративных мультимодальных моделях, таких как GPT-4o или Flamingo, декодер обычно представляет собой преобразователь, обученный создавать последовательности текста, учитывающие как языковые, так и неязыковые входные данные.

В большинстве мультимодальных систем используются два этапа:

- Предварительная подготовка: Крупномасштабные наборы данных с парными модальностями (например, изображение-текст или видеотекст) используются для изучения представлений общего назначения. Этот этап часто проходит под наблюдением самостоятельно.

Тонкая настройка: Затем модель адаптируется к конкретным задачам с использованием небольших контролируемых наборов данных. Некоторые новые модели поддерживают прямое обучение с нуля или несколькими выстрелами без дополнительного обучения.

Узнайте больше о синтетические носители.

Популярные мультимодальные модели искусственного интеллекта

1. CLIP (предварительная тренировка контрастного языка и изображений) — OpenAI

Выпущен: 2021

Процедуры: Текст и изображение

Ключевые характеристики:

- Обучался работе с 400 миллионами пар изображений и текста, взятых из Интернета.

- Изучает совместное пространство для встраивания изображений и текста с помощью сравнительного обучения.

- Может выполнять классификацию изображений с нулевым снимком, сопоставляя вложенные изображения с метками на естественном языке.

Воздействие: Установите новый стандарт гибких задач на языке машинного зрения без тонкой настройки.

2. ДАЛЛ·Э/ЭТАЛ·Е 2 — Пенай

Выпущен: 2021/2022

Процедуры: преобразование текста в изображение (генеративное преобразование)

Ключевые характеристики:

- Создает изображения на основе подсказок на естественном языке.

- DALL·E 2 улучшило разрешение, реалистичность и возможности редактирования.

Воздействие: Открыл путь к креативным инструментам искусственного интеллекта и показал, как текст может точно управлять генерацией изображений.

3. Фламинго — DeepMind

Выпущен: 2022

Процедуры: текст, изображение, видео

Ключевые характеристики:

- Предназначен для краткого обучения мультимодальным задачам.

- Сочетает в себе кодировщик замороженного зрения с предварительно обученной языковой моделью и слоями перекрестного внимания.

Воздействие: Продемонстрировал высокие результаты по нескольким тестам на язык видения при минимальном обучении конкретным задачам.

4. Palm-e — исследование Google

Выпущен: 2023

Процедуры: Ввод текста, изображения, датчика робота

Ключевые характеристики:

- Встраивает реальные данные управления роботом в большую языковую модель (PalM).

- Позволяет роботам следовать мультимодальным инструкциям, таким как «иди на кухню и поищи красную кружку».

Воздействие: Показал, как языковые модели могут быть основаны на физической среде и воплощенных агентах.

5. GPT-4 со зрением (GPT-4V) /GPT-4o — OpenAI

Выпущен: GPT-4V (2023), GPT-4o (2024)

Процедуры: Текст, изображение, аудио, видео

Ключевые характеристики:

- GPT-4V ввел в GPT-4 ввод изображения.

- GPT-4o («omni») изначально интегрирует все модальности, включая голосовой ввод и вывод в реальном времени.

- Единая модель обрабатывает и генерирует разные модальности.

Воздействие: Переходит к использованию унифицированных помощников искусственного интеллекта в режиме реального времени, способных понимать зрение, речь и текст.

6. «Космос-1»/«Космос-2» — исследования Microsoft

Выпущен: 2023

Процедуры: Текст и изображение

Ключевые характеристики:

- Объединяет видение и язык благодаря глубокому пониманию.

- «Космос-2» ввел объектное обоснование пространственного мышления.

Воздействие: Сосредоточен на изучении знаний и логическом мышлении при выполнении общих разведывательных задач.

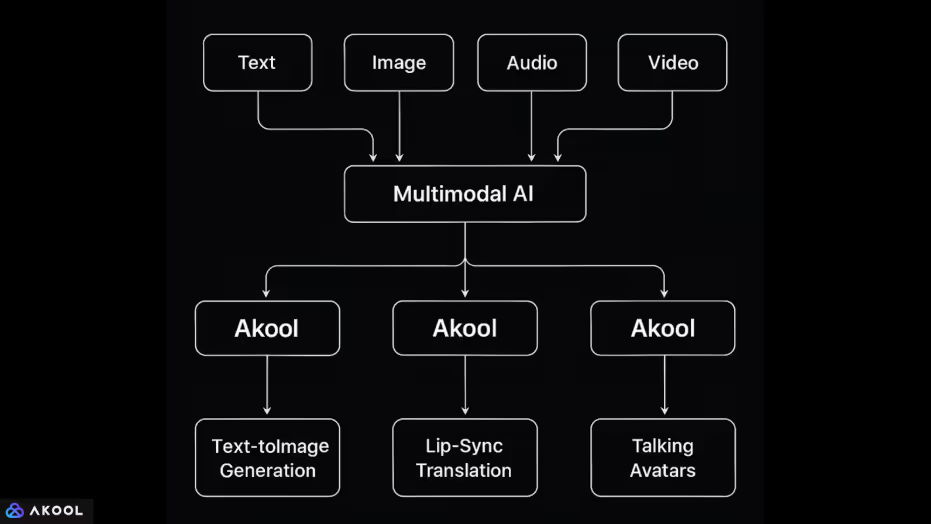

Как Akool использует мультимодальный искусственный интеллект

Akool — это платформа, объединяющая множество способов обработки данных: текст, изображение, аудио и видео в единой среде, управляемой искусственным интеллектом.

Эта интеграция позволяет выполнять сложные мультимедийные задачи, требующие понимания и генерации модели для разных типов входных данных. Вот как обрабатывается и комбинируется каждый метод:

1. Текст и изображение

- Генерация текста в изображение: Пользователи могут вводить подсказки для создания изображений. Для этого система должна сопоставлять входные данные на естественном языке с визуальным контентом с использованием общего пространства представления, аналогично таким моделям, как DALL·E или Stable Diffusion.

- Редактирование изображений с помощью подсказок: Пользователи могут изменять изображения (менять фон, освещение, позу и т. д.), используя естественный язык, демонстрируя способность системы согласовывать текстовые инструкции с визуальными преобразованиями.

2. Изображение + аудио + видео

- Смена лиц и анимация аватара: Akool позволяет пользователям анимировать лица на фотографиях с помощью аудиовхода или текстовых сценариев. Для этого необходимо сопоставлять контуры лица по изображению с помощью синхронизации звука или текста на уровне фонемы, синхронизировать движения и выражение лица в разных модальностях.

- Перевод с синхронизацией губ: Платформа может переводить устную речь на другой язык и изменять движение губ говорящего на видео в соответствии с переведенной речью. Это сочетает в себе:

- преобразование аудио в текст (распознавание речи),

- перевод текста (обработка естественного языка),

- преобразование текста в аудио (синтез речи),

- Повторный рендеринг видео (визуальное редактирование с моделированием движения).

- преобразование аудио в текст (распознавание речи),

3. Текст + аудио + видео

- Говорящие аватара: Пользователь может ввести сценарий (текст), который синтезируется в речь и анимируется с помощью виртуального аватара. Система сопоставляет текст с голосом, а голос — с движениями лица, сочетая генерацию естественного языка, преобразование текста в речь и анимацию лица.

- Живые аватары AI: Функция Live Camera позволяет пользователям отображаться в качестве аватаров на видеоконференциях. Здесь аудиоввод (речь) в реальном времени и, возможно, видеотрансляция лица (выражение лица) сопоставляются с искусственным анимированным персонажем.