マルチモーダルAIとは、テキスト、画像、音声、動画など、複数の種類のデータを理解して情報を生成できるシステムを指します。単一モダリティで動作する従来の AI モデルとは異なり、マルチモーダルモデルは複数のソースからの情報を一度に処理して統合するように設計されています。

これにより、より正確な推論、より豊富な対話、および現実世界のタスクへの幅広い適用が可能になります。

音声と視覚入力を処理するGPT-4の能力から、医療診断、ロボット工学、メディア生成の用途に至るまで、マルチモーダルAIは、機械が世界を認識して対応する方法の中心になりつつあります。

マルチモーダル AI を理解する:定義と基本

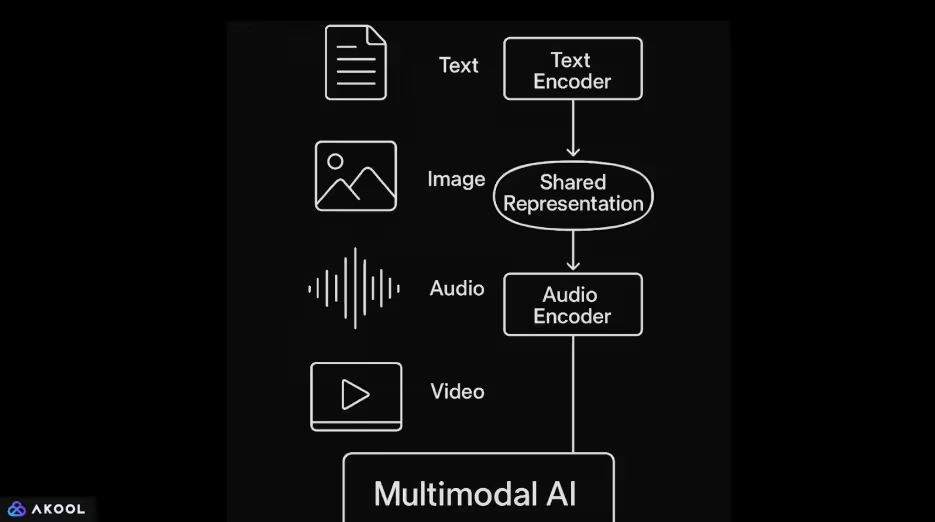

マルチモーダルAIシステムは、テキスト、画像、音声、動画などのさまざまなタイプのデータを1つのモデルに組み合わせます。専用のエンコーダーがまず各入力を処理します。トランスフォーマーベースの言語モデルは通常、テキストを処理します。画像は畳み込みニューラルネットワークまたはビジョントランスフォーマーを使用して処理されます。オーディオは多くの場合、スペクトログラムベースのモデルまたは波形トランスフォーマーを使用してエンコードされます。

各入力がベクトル表現にエンコードされると、モデルはこれらのベクトルを共有潜在空間にマッピングします。

この共有スペースにより、システムはモダリティ間の関係を学習できます。たとえば、キャプションを画像にリンクしたり、話されたフレーズを関連するビデオコンテンツと一致させたりできます。アテンション・メカニズムは、こうしたインプット全体にわたる情報を首尾一貫した方法で整列させ統合するためによく使用されます。

マルチモーダルAIは、より柔軟でコンテキストに応じたアウトプットを可能にします。1 つのモデルで、自然言語による画像の記述、ビデオコンテンツに関する質問への回答、テキストとビジュアルの組み合わせに基づく回答の生成などのタスクを実行できます。

についてさらに詳しく マルチモーダル AI エージェント。

マルチモーダル AI と従来の AI の違い

マルチモーダルAIの基礎は、画像キャプションと視覚的な質問応答の初期の研究によって築かれました。著しい進歩は、畳み込みネットワークとリカレント言語モデルを組み合わせたShow and Tell(Google、2015年)のようなモデルから始まりました。FAIR (Facebook AI Research) と OpenAI の研究では、テキストと画像のペアのデータセットで大規模にトレーニングされたアーキテクチャによって、この分野がさらに発展しました。

2021年にOpenAIによってリリースされたCLIP(対照言語—イメージ・プレトレーニング)は、大きな転換点を迎えました。CLIPは自然言語監視から直接視覚概念を学んだため、微調整をしなくても幅広い画像分類タスクに汎用化できるようになりました。

続いてDALL·E、DeepMindの「フラミンゴ」、そして最近ではビジョン機能を搭載したGPT-4が続きました。

これらの開発は、タスク固有のパイプラインから、統一されたフレームワーク内で複数の入力タイプを処理できる汎用モデルへの移行を反映しています。

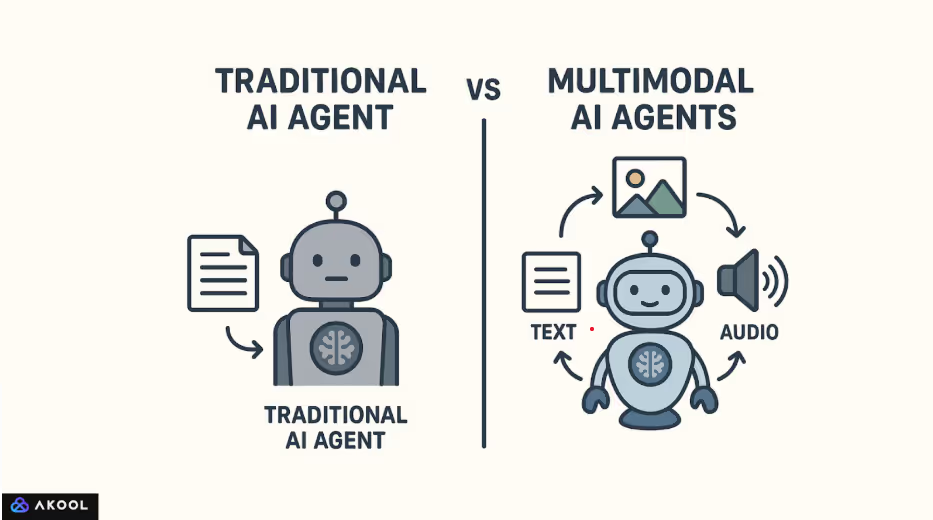

従来のAIモデルは通常、単一タイプの入力を処理するように設計されています。たとえば、GPT-2 のような言語モデルはテキストのみで学習されるのに対し、ResNet のような畳み込みニューラルネットワークは画像分類用に最適化されています。

これらのモデルは分離された領域内で機能するため、さまざまなモダリティにわたって情報を自然に解釈したり関連付けたりすることはできません。

これとは対照的に、マルチモーダルAIは、1つのシステム内で複数のタイプのデータを処理して組み合わせるように構築されています。テキスト、画像、音声を個別のストリームとして扱うのではなく、それらを共通の表現空間にエンコードします。この共有スペースにより、モデルはモダリティ間のつながりを描くことができます。

たとえば、画像にキャプションを関連付けたり、音声を視覚的なシーンに合わせたり、生成されたビデオフレームで話し言葉に応答したりできます。

マルチモーダル AI の仕組み:テクニカルコンポーネント

マルチモーダルAIは、テキスト、画像、音声、動画などの複数のタイプの入力データを1つのシステムで処理、整列、推論できるようにすることで機能します。

各データタイプを個別に扱うのではなく、各モダリティを比較、組み合わせ、下流のタスクで共同使用できる形式に変換することで、共通の理解が生まれます。

1。各モダリティのエンコーディング

このプロセスは、生の入力を構造化された表現にエンコードすることから始まります。

- [テキスト] セマンティクスと構文をキャプチャするトランスフォーマーベースの言語モデルを使用してエンコードされています。

- 画像 畳み込みニューラルネットワークまたはビジョントランスフォーマーを介して処理され、視覚的特徴が抽出されます。

- オーディオ スペクトログラムに変換されるか、Wav2VecやAudioMaeなどの専用エンコーダーを使用して波形として直接処理されます。

- ビデオ 空間的処理と時間的処理の両方を伴い、多くの場合、3D CNNまたは時間認識型注意メカニズムを使用します。

各エンコーダーは、入力を最も関連性の高い特徴を捉える高次元ベクトルに変換します。

2。共有表現空間へのマッピング

エンコードされたベクトルは共有の潜在空間に投影され、そこでさまざまなモダリティからの情報を比較できるようになります。この空間は、画像やキャプションなど、意味的に類似したコンテンツが互いに接近するようにトレーニングされています。CLIP のようなモデルは、対照学習を使用してこれを実現しています。対照学習では、一致するペアをまとめ、一致しないペアを引き離します。

この共有スペースは、クロスモーダル理解を可能にする中核的な要素です。これにより、たとえば、モデルがテキストクエリに基づいて画像を取得したり、視覚入力に基づいてテキストを生成したりできます。

3。クロスモーダルアライメントとフュージョン

エンコードされると、さまざまなモダリティからの情報が注意メカニズムと融合層を通じて統合されます。ここで、モデルは各モダリティの関連部分を揃える方法を学習します。たとえば、文中の単語を画像内の特定の領域にリンクさせるなどです。

フュージョン戦略はアーキテクチャによって異なります。

- 初期融合 ディーププロセッシングの前に入力を結合します。

- 後期融合 各モダリティが個別に処理された後に出力をマージします。

- 中間(関節)融合 は最も効果的で一般的に使用されており、モデルの複数のレベルで豊富なインタラクションを可能にします。

4。共同推論とアウトプットの生成

整合されたマルチモーダル表現により、モデルはすべての入力タイプをまとめて理解する必要があるタスクを実行できます。画像のテキストによる説明を生成したり、ビデオに関する質問に答えたり、視覚的背景に基づいた音声対話を実行したりできます。

デコーダーまたはタスク固有のヘッドは、融合された表現を出力に変換します。GPT-4o や Flamingo のような生成型マルチモーダルモデルでは、デコーダーは通常、言語入力と非言語入力の両方を条件として、テキストのシーケンスを生成するようにトレーニングされたトランスフォーマーです。

ほとんどのマルチモーダルシステムでは、次の 2 つのフェーズを使用します。

- 事前訓練:モダリティがペアになっている大規模なデータセット(画像-テキストやビデオ-テキストなど)を使用して、汎用の表現を学習します。多くの場合、このフェーズは自分で指導します。

微調整: 次に、より小さな教師付きデータセットを使用して、モデルを特定のタスクに適合させます。新しいモデルの中には、追加のトレーニングなしで、ゼロショット学習や数ショット学習を直接サポートするものもあります。

についてさらに詳しく 合成メディア。

人気のマルチモーダル AI モデル

1。CLIP (コントラクティブ・ランゲージ—イメージ・プレトレーニング) — OpenAI

リリース済み: 2021

モダリティ: テキストと画像

主な機能:

- インターネットからスクレイピングされた4億の画像とテキストのペアでトレーニングしました。

- 対照学習を使用して、画像やテキスト用の共有埋め込みスペースを学習します。

- 画像の埋め込みを自然言語ラベルと照合することで、ゼロショット画像分類を実行できます。

インパクト: 微調整を必要としない柔軟なビジョン言語タスクの新しい基準を打ち立てます。

2。DAL·E/DAL·E 2 — オープンAI

リリース済み: 2021/2022

モダリティ: テキストから画像へ (ジェネレーティブ)

主な機能:

- 自然言語プロンプトから画像を生成します。

- DALL·E 2 では、解像度、リアリズム、編集機能が向上しました。

インパクト: クリエイティブなAIツールへの扉を開き、テキストが画像生成を正確に制御する方法を示しました。

3。フラミンゴ — ディープマインド

リリース済み: 2022

モダリティ: テキスト、画像、動画

主な機能:

- マルチモーダルタスクでの数回の学習用に設計されています。

- フローズンビジョンエンコーダーと、事前にトレーニングされた言語モデルおよびクロスアテンションレイヤーを組み合わせます。

インパクト: タスク特有のトレーニングをほとんど受けずに、複数のビジョン言語ベンチマークで優れたパフォーマンスを示しました。

4。Palm-e — グーグルリサーチ

リリース済み: 2023

モダリティ: テキスト、画像、ロボットセンサー入力

主な機能:

- 現実世界のロボット制御入力を大規模言語モデル (PalM) に埋め込みます。

- ロボットが「キッチンに行って赤いマグカップを探して」など、マルチモーダルな指示に従うことができます。

インパクト: 言語モデルを物理環境と具現化されたエージェントにどのように根付かせることができるかを示しました。

5。ビジョン付き GPT-4 (GPT-4V) /GPT-4O — OpenAI

リリース済み: GPT-4V (2023)、GPT-4 (2024)

モダリティ: テキスト、画像、オーディオ、ビデオ

主な機能:

- GPT-4VはGPT-4にイメージ入力を導入しました。

- GPT-4o(「オムニ」)は、リアルタイムの音声入力と出力を含むすべてのモダリティをネイティブに統合します。

- 単一モデルで複数のモダリティを処理および生成します。

インパクト: 視覚、音声、テキストを理解できるリアルタイムの統合AIアシスタントに移行します。

6。コスモス-1 /コスモス-2 — マイクロソフトリサーチ

リリース済み: 2023

モダリティ: テキストと画像

主な機能:

- 基礎的な理解を通じてビジョンと言語を組み合わせます。

- Kosmos-2では、空間的推論のためのオブジェクトグラウンディングが導入されました。

インパクト:一般的な知能タスクにおける知識の基盤とビジョン言語による推論に焦点を当てています。

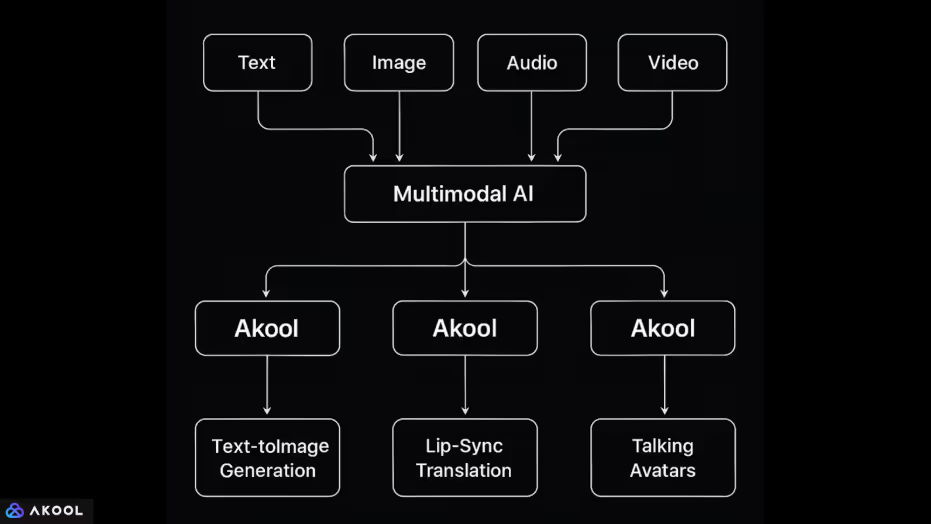

AkoolがマルチモーダルAIを使用する方法

Akoolは、テキスト、画像、音声、動画といった複数のデータモダリティを単一のAI主導型環境内に統合するプラットフォームです。

この統合により、モデルがさまざまな入力タイプを理解して生成する必要がある複雑なメディアタスクを実行できます。各モダリティの処理方法と組み合わせ方法は次のとおりです。

1。テキスト + 画像

- テキストから画像への生成: ユーザーはプロンプトを入力して画像を生成できます。そのためには、システムが、DALL·E や Stable Diffusion などのモデルと同様に、共有表現空間を使用して自然言語入力をビジュアルコンテンツにマッピングする必要があります。

- プロンプトによる画像編集: ユーザーは自然言語を使用して画像を変更(背景、照明、ポーズなどを変更)できます。これにより、テキストによる指示を視覚的変換に合わせて調整するシステムの機能がわかります。

2。画像 + 音声 + 動画

- フェイススワッピングとアバターアニメーション:Akoolを使用すると、ユーザーは音声入力またはテキストスクリプトを使用して写真の顔をアニメーション化できます。そのためには、音素レベルの音声またはテキストのタイミングに合わせて画像内の顔のランドマークを揃え、モダリティ全体で動きと表情を同期させる必要があります。

- リップシンク翻訳: このプラットフォームでは、音声を別の言語に翻訳したり、翻訳された音声に合わせてビデオ内の話者の唇の動きを変更したりできます。これは以下を組み合わせたものです。

- 音声からテキストへ (音声認識)、

- テキスト翻訳 (自然言語処理)

- テキストから音声へ(音声合成)、

- ビデオの再レンダリング (モーションモデリングによるビジュアル編集)。

- 音声からテキストへ (音声認識)、

3。テキスト + オーディオ + ビデオ

- トーキングアバター: ユーザーはスクリプト(テキスト)を入力できます。スクリプト(テキスト)は音声に合成され、仮想アバターを使用してアニメーション化されます。このシステムは、自然言語生成、音声を音声合成、顔のアニメーションをブレンドして、テキストを音声に、音声を顔の動きにマッピングします。

- ライブ AI アバター:ライブカメラ機能を使用すると、ユーザーはビデオ会議にアバターとして登場できます。ここでは、リアルタイムの音声入力 (音声) と、場合によっては顔のビデオフィード (表情) が合成アニメーションキャラクターにマッピングされます。