Multimodale KI bezieht sich auf Systeme, die Informationen aus verschiedenen Datentypen, einschließlich Text, Bildern, Audio und Video, verstehen und generieren können. Im Gegensatz zu herkömmlichen KI-Modellen, die mit einer einzigen Modalität arbeiten, sind multimodale Modelle so konzipiert, dass sie Informationen aus mehreren Quellen gleichzeitig verarbeiten und integrieren.

Dies ermöglicht genaueres Denken, umfassendere Interaktionen und eine breitere Anwendung bei realen Aufgaben.

Von der Fähigkeit des GPT-4, sprachliche und visuelle Eingaben zu verarbeiten, bis hin zu Anwendungen in der Gesundheitsdiagnostik, Robotik und Mediengenerierung wird multimodale KI schnell zu einem zentralen Faktor dafür, wie Maschinen die Welt wahrnehmen und darauf reagieren.

Multimodale KI verstehen: Definition und Grundlagen

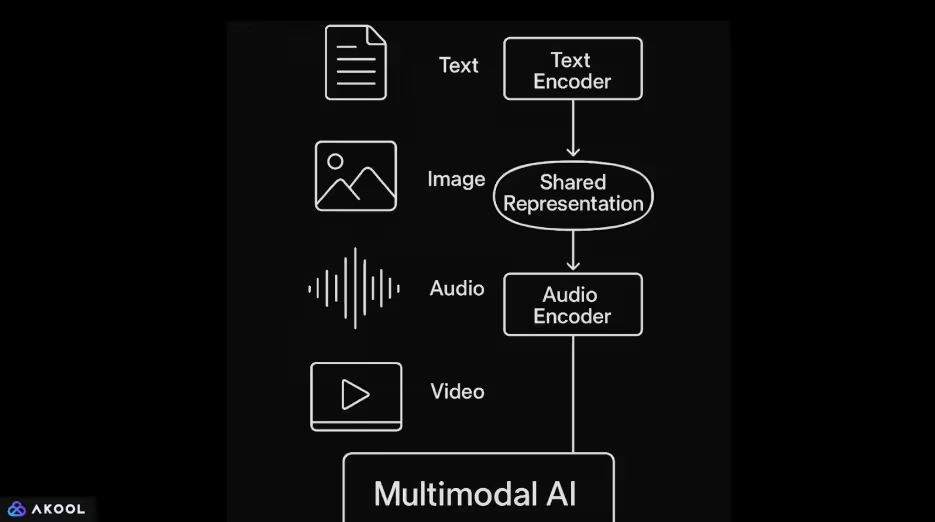

Multimodale KI-Systeme kombinieren verschiedene Datentypen wie Text, Bilder, Audio und Video in einem einzigen Modell. Ein dedizierter Encoder verarbeitet zunächst jede Eingabe. Transformer-basierte Sprachmodelle verarbeiten in der Regel Text. Bilder werden mithilfe neuronaler Faltungsnetzwerke oder Bildtransformatoren verarbeitet. Audio wird häufig mit spektrogrammbasierten Modellen oder Wellenformtransformatoren kodiert.

Sobald jede Eingabe in eine Vektordarstellung kodiert ist, ordnet das Modell diese Vektoren einem gemeinsamen latenten Raum zu.

Dieser gemeinsame Raum ermöglicht es dem System, modalitätsübergreifende Beziehungen zu lernen. Es kann beispielsweise eine Bildunterschrift mit einem Bild verknüpfen oder eine gesprochene Phrase mit relevanten Videoinhalten abgleichen. Aufmerksamkeitsmechanismen werden häufig verwendet, um Informationen über diese Eingaben hinweg auf kohärente Weise aufeinander abzustimmen und zu integrieren.

Multimodale KI ermöglicht flexiblere und kontextbewusstere Ausgaben. Ein einzelnes Modell kann Aufgaben wie die Beschreibung von Bildern in natürlicher Sprache, die Beantwortung von Fragen zu Videoinhalten oder das Generieren von Antworten auf der Grundlage einer Kombination aus Text und Bildern ausführen.

Erfahre mehr über multimodale KI-Agenten.

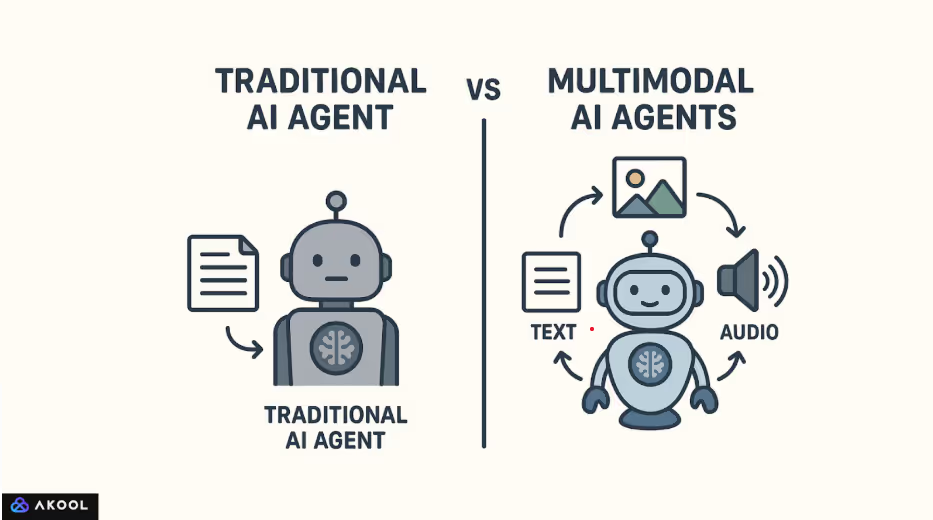

Wie sich multimodale KI von traditioneller KI unterscheidet

Der Grundstein für multimodale KI wurde durch frühe Arbeiten zur Bilduntertitelung und visuellen Beantwortung von Fragen gelegt. Bemerkenswerte Fortschritte begannen mit Modellen wie Show and Tell (Google, 2015), die Faltungsnetzwerke mit wiederkehrenden Sprachmodellen kombinierten. Die Forschung bei FAIR (Facebook AI Research) und OpenAI brachte das Feld mit Architekturen, die auf gepaarten Text-Bild-Datensätzen im großen Maßstab trainiert wurden, weiter voran.

CLIP (Contrastive Language—Image Pretraining), 2021 von OpenAI veröffentlicht, markierte einen großen Wendepunkt. CLIP erlernte visuelle Konzepte direkt durch die Überwachung natürlicher Sprache, sodass es ohne Feinabstimmung auf eine Vielzahl von Bildklassifizierungsaufgaben übertragen werden konnte.

Darauf folgten DALL·E, Flamingo von DeepMind und in jüngerer Zeit GPT-4 mit Bildverarbeitungsfunktionen.

Diese Entwicklungen spiegeln eine Verlagerung von aufgabenspezifischen Pipelines hin zu Allzweckmodellen wider, die mehrere Eingabetypen innerhalb eines einheitlichen Frameworks verarbeiten können.

Herkömmliche KI-Modelle sind in der Regel so konzipiert, dass sie eine einzige Art von Eingabe verarbeiten. Beispielsweise wird ein Sprachmodell wie GPT-2 nur mit Text trainiert, während ein neuronales Faltungsnetzwerk wie ResNet für die Bildklassifizierung optimiert ist.

Diese Modelle operieren in isolierten Bereichen und können Informationen nicht auf natürliche Weise über verschiedene Modalitäten hinweg interpretieren oder miteinander in Beziehung setzen.

Multimodale KI ist dagegen darauf ausgelegt, mehrere Datentypen in einem einzigen System zu verarbeiten und zu kombinieren. Sie behandelt Text, Bilder oder Audio nicht als separate Streams, sondern kodiert sie stattdessen in einem gemeinsamen Repräsentationsraum. Dieser gemeinsame Raum ermöglicht es dem Modell, Verbindungen zwischen den Modalitäten herzustellen.

Es kann beispielsweise ein Bild mit einer Bildunterschrift verknüpfen, einen Ton einer visuellen Szene zuordnen oder mit einem generierten Videobild auf gesprochene Sprache reagieren.

So funktioniert multimodale KI: Technische Komponenten

Multimodale KI ermöglicht es einem einzigen System, mehrere Arten von Eingabedaten wie Text, Bild, Audio und Video zu verarbeiten, auszurichten und zu begründen.

Anstatt jeden Datentyp isoliert zu behandeln, entsteht ein gemeinsames Verständnis, indem jede Modalität in eine Form übersetzt wird, die verglichen, kombiniert und gemeinsam in nachgelagerten Aufgaben verwendet werden kann.

1. Kodierung jeder Modalität

Der Prozess beginnt mit der Kodierung von Roheingaben in strukturierte Repräsentationen:

- Text wird mithilfe transformatorbasierter Sprachmodelle kodiert, die Semantik und Syntax erfassen.

- Bilder werden durch neuronale Faltungsnetzwerke oder Bildtransformatoren verarbeitet, um visuelle Merkmale zu extrahieren.

- Audio wird in Spektrogramme umgewandelt oder mit speziellen Encodern wie Wav2Vec oder AudioMAE direkt als Wellenformen verarbeitet.

- Video beinhaltet sowohl räumliche als auch zeitliche Verarbeitung, häufig unter Verwendung von 3D-CNNs oder zeitbezogenen Aufmerksamkeitsmechanismen.

Jeder Encoder wandelt die Eingabe in einen hochdimensionalen Vektor um, der die wichtigsten Merkmale erfasst.

2. Zuordnung zu einem gemeinsamen Repräsentationsraum

Die kodierten Vektoren werden in einen gemeinsamen Latenzraum projiziert, in dem Informationen aus verschiedenen Modalitäten vergleichbar werden. Dieser Raum ist so trainiert, dass semantisch ähnliche Inhalte, wie z. B. ein Bild und seine Bildunterschrift, dicht beieinander liegen. Modelle wie CLIP erreichen dies durch kontrastives Lernen, bei dem übereinstimmende Paare zusammengezogen und nicht übereinstimmende Paare auseinandergeschoben werden.

Dieser gemeinsame Raum ist die zentrale Voraussetzung für ein modalübergreifendes Verständnis. Es ermöglicht beispielsweise einem Modell, ein Bild auf der Grundlage einer Textabfrage abzurufen oder Text auf der Grundlage visueller Eingaben zu generieren.

3. Modalübergreifende Ausrichtung und Fusion

Nach der Kodierung werden die Informationen aus verschiedenen Modalitäten durch Aufmerksamkeitsmechanismen und Fusionsebenen integriert. Hier lernt das Modell, die relevanten Teile der einzelnen Modalitäten aufeinander abzustimmen — beispielsweise indem es ein Wort in einem Satz mit einer bestimmten Region in einem Bild verknüpft.

Die Fusionsstrategien variieren je nach Architektur:

- Frühe Fusion kombiniert Eingaben vor jeder tiefen Verarbeitung.

- Späte Fusion führt Ausgaben zusammen, nachdem jede Modalität unabhängig verarbeitet wurde.

- Intermediäre (Gelenk-) Fusion ist die effektivste und am häufigsten verwendete und ermöglicht umfangreiche Interaktionen auf mehreren Ebenen des Modells.

4. Gemeinsames Denken und Generierung von Ergebnissen

Mit abgestimmten multimodalen Repräsentationen kann das Modell Aufgaben ausführen, für die ein gemeinsames Verständnis aller Eingabetypen erforderlich ist. Es kann eine Textbeschreibung eines Bildes generieren, Fragen zu einem Video beantworten oder einen gesprochenen Dialog führen, der auf dem visuellen Kontext basiert.

Ein Decoder oder ein aufgabenspezifischer Kopf wandelt die fusionierten Repräsentationen in Ausgänge um. In generativen multimodalen Modellen wie GPT-4o oder Flamingo ist der Decoder in der Regel ein Transformator, der darauf trainiert ist, Textsequenzen zu erzeugen, die sowohl auf sprachlichen als auch auf nichtsprachlichen Eingaben basieren.

Die meisten multimodalen Systeme verwenden zwei Phasen:

- Vortraining: Große Datensätze mit gepaarten Modalitäten (wie Bildtext oder Videotext) werden verwendet, um allgemeine Repräsentationen zu lernen. Diese Phase wird oft selbst überwacht.

Feinabstimmung: Das Modell wird dann mithilfe kleinerer, überwachter Datensätze an spezifische Aufgaben angepasst. Einige neuere Modelle unterstützen das Zero-Shot- oder Few-Shot-Lernen direkt, ohne weiteres Training.

Erfahre mehr über synthetische Medien.

Beliebte multimodale KI-Modelle

1. CLIP (Kontrastive Sprache — Bildvortraining) — OpenAI

Freigegeben: 2021

Modalitäten: Text und Bild

Die wichtigsten Funktionen:

- Trainiert mit 400 Millionen Bild-Text-Paaren, die aus dem Internet geklaut wurden.

- Erlernt mithilfe von kontrastivem Lernen einen gemeinsamen Einbettungsraum für Bilder und Text.

- Kann eine Zero-shot-Bildklassifizierung durchführen, indem Bildeinbettungen mit Bezeichnungen in natürlicher Sprache abgeglichen werden.

Auswirkung: Setzen Sie einen neuen Standard für flexible Aufgaben in der Bildverarbeitung ohne Feinabstimmung.

2. DALL·E//DALL·E 2 — OpenAI

Freigegeben: 2021/2022

Modalitäten: Text zum Bild (generativ)

Die wichtigsten Funktionen:

- Generiert Bilder aus Eingabeaufforderungen in natürlicher Sprache.

- DALL·E 2 verbesserte Auflösungs-, Realismus- und Bearbeitungsfunktionen.

Auswirkung: Öffnete die Tür zu kreativen KI-Tools und zeigte, wie Text die Bildgenerierung präzise steuern kann.

3. Flamingo — DeepMind

Freigegeben: 2022

Modalitäten: Text, Bild, Video

Die wichtigsten Funktionen:

- Konzipiert für das Lernen in wenigen Schüssen bei multimodalen Aufgaben.

- Kombiniert einen eingefrorenen Vision-Encoder mit einem vortrainierten Sprachmodell und Cross-Attention-Layern.

Auswirkung: Es wurde eine starke Leistung bei mehreren Benchmarks im Bereich Vision Language nachgewiesen, wobei nur sehr wenig aufgabenspezifisches Training erforderlich war.

4. Palm-e — Google-Forschung

Freigegeben: 2023

Modalitäten: Text, Bild, Roboter-Sensoreingang

Die wichtigsten Funktionen:

- Bettet reale Robotersteuerungseingaben in ein Large Language Model (PALM) ein.

- Ermöglicht Robotern, multimodalen Anweisungen zu folgen, wie zum Beispiel „Geh in die Küche und suche nach einer roten Tasse“.

Auswirkung: Es wurde gezeigt, wie Sprachmodelle auf physischen Umgebungen und verkörperten Agenten basieren können.

5. GPT-4 mit Vision (GPT-4V)/GPT-4o — OpenAI

Freigegeben: GPT-4 V (2023), GPT-4 o (2024)

Modalitäten: Text, Bild, Audio, Video

Die wichtigsten Funktionen:

- GPT-4V führte die Bildeingabe für GPT-4 ein.

- GPT-4o („Omni“) integriert alle Modalitäten nativ, einschließlich Spracheingabe und -ausgabe in Echtzeit.

- Ein einziges Modell verarbeitet und generiert modalitätsübergreifend.

Auswirkung: Geht zu vereinheitlichten KI-Assistenten in Echtzeit mit Bild-, Sprach- und Textverständnis über.

6. Kosmos-1/Kosmos-2 — Microsoft Research

Freigegeben: 2023

Modalitäten: Text und Bild

Die wichtigsten Funktionen:

- Kombiniert Vision und Sprache durch fundiertes Verständnis.

- Kosmos-2 führte die Objekterdung für räumliches Denken ein.

Auswirkung: Konzentriert sich auf Wissensgrundlagen und visionssprachliches Denken bei allgemeinen nachrichtendienstlichen Aufgaben.

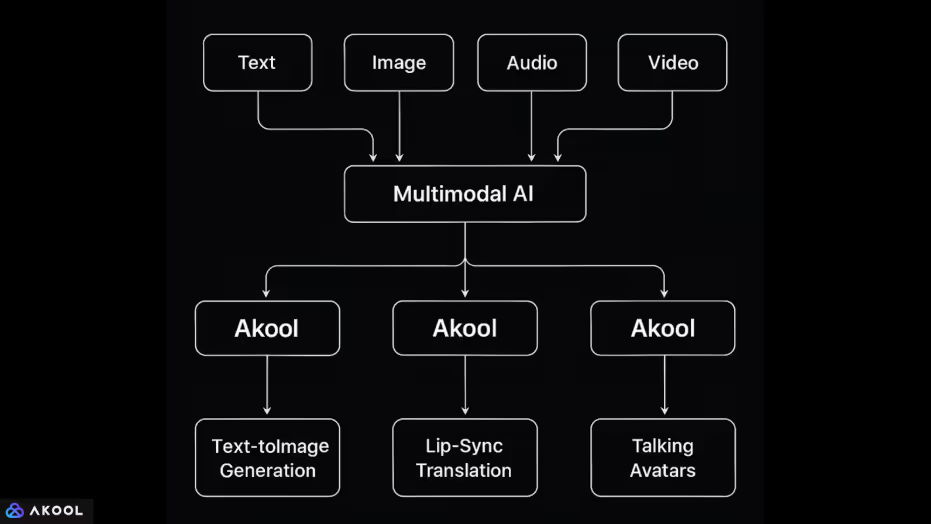

Wie Akool multimodale KI einsetzt

Akool ist eine Plattform, die mehrere Datenmodalitäten integriert: Text, Bild, Audio und Video in einer einzigen KI-gesteuerten Umgebung.

Diese Integration ermöglicht es, komplexe Medienaufgaben auszuführen, für die das Modell verschiedene Eingabetypen verstehen und generieren muss. So wird jede Modalität behandelt und kombiniert:

1. Text + Bild

- Generierung von Text zu Bild: Benutzer können Eingabeaufforderungen eingeben, um Bilder zu generieren. Dazu muss das System Eingaben in natürlicher Sprache visuellen Inhalten zuordnen und dabei einen gemeinsamen Darstellungsraum verwenden, ähnlich wie bei Modellen wie DALL·E oder Stable Diffusion.

- Bildbearbeitung über Eingabeaufforderungen: Benutzer können Bilder in natürlicher Sprache modifizieren (Hintergrund, Beleuchtung, Pose usw. ändern), was zeigt, dass das System in der Lage ist, Textanweisungen an visuellen Transformationen auszurichten.

2. Bild + Audio + Video

- Gesichtstausch und Avatar-Animation: Akool ermöglicht es Benutzern, Gesichter in Fotos mithilfe von Audioeingaben oder Textskripten zu animieren. Dazu müssen die Gesichtsmarkierungen auf einem Bild mit Ton- oder Text-Timing auf Phonemebene ausgerichtet werden, wobei Bewegung und Ausdruck modalitätsübergreifend synchronisiert werden.

- Lippensynchrone Übersetzung: Die Plattform kann gesprochenes Audio in eine andere Sprache übersetzen und die Lippenbewegung des Sprechers im Video an die übersetzte Sprache anpassen. Dies kombiniert:

- Audio-zu-Text (Spracherkennung),

- Textübersetzung (Verarbeitung natürlicher Sprache),

- Text-zu-Audio (Sprachsynthese),

- Erneutes Rendern von Videos (visuelle Bearbeitung mit Bewegungsmodellierung).

- Audio-zu-Text (Spracherkennung),

3. Text + Audio + Video

- Sprechende Avatare: Ein Benutzer kann ein Skript (Text) eingeben, das zu Sprache synthetisiert und mithilfe eines virtuellen Avatars animiert wird. Das System ordnet Text der Stimme und die Stimme der Gesichtsbewegung zu und kombiniert dabei natürliche Sprachgenerierung, Text-to-Speech und Gesichtsanimation.

- Live-KI-Avatare: Mit der Live-Kamera-Funktion können Benutzer in Videokonferenzen als Avatare auftreten. Hier werden Audioeingaben (Sprache) in Echtzeit und möglicherweise Gesichtsvideos (Gesichtsausdruck) einer synthetischen animierten Figur zugeordnet.