La IA multimodal se refiere a los sistemas que pueden comprender y generar información en varios tipos de datos, incluidos texto, imágenes, audio y vídeo. A diferencia de los modelos de IA tradicionales que funcionan con una única modalidad, los modelos multimodales están diseñados para procesar e integrar información de varias fuentes a la vez.

Esto permite un razonamiento más preciso, interacciones más ricas y una aplicación más amplia en tareas del mundo real.

Desde la capacidad del GPT-4 para gestionar las entradas visuales y de voz hasta las aplicaciones en el diagnóstico sanitario, la robótica y la generación de medios, la IA multimodal se está convirtiendo rápidamente en un elemento central de la forma en que las máquinas sienten el mundo y responden a él.

Comprensión de la IA multimodal: definición y conceptos básicos

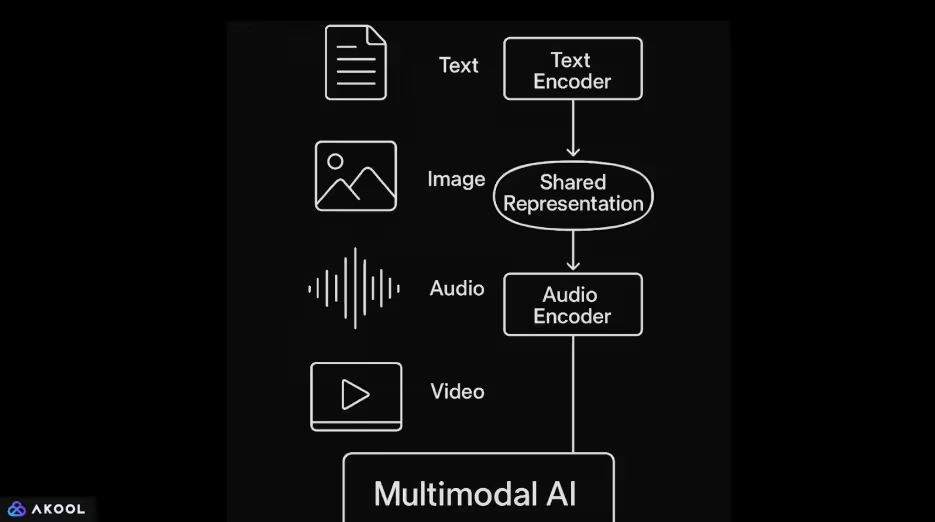

Los sistemas de IA multimodales combinan diferentes tipos de datos, como texto, imágenes, audio y vídeo, en un único modelo. En primer lugar, un codificador dedicado procesa cada entrada. Los modelos de lenguaje basados en transformadores normalmente manejan texto. Las imágenes se procesan mediante redes neuronales convolucionales o transformadores de visión. El audio se codifica con frecuencia mediante modelos basados en espectrogramas o transformadores de forma de onda.

Una vez que cada entrada se codifica en una representación vectorial, el modelo mapea estos vectores en un espacio latente compartido.

Este espacio compartido permite que el sistema aprenda las relaciones entre las distintas modalidades. Por ejemplo, puede vincular un subtítulo a una imagen o hacer coincidir una frase hablada con contenido de vídeo relevante. Los mecanismos de atención se utilizan con frecuencia para alinear e integrar la información de estas entradas de manera coherente.

La IA multimodal permite obtener resultados más flexibles y sensibles al contexto. Un único modelo puede realizar tareas como describir imágenes en lenguaje natural, responder preguntas sobre el contenido de vídeo o generar respuestas basadas en una combinación de texto e imágenes.

Obtenga más información sobre agentes de IA multimodales.

En qué se diferencia la IA multimodal de la IA tradicional

La base de la IA multimodal se estableció con los primeros trabajos en el subtitulado de imágenes y la respuesta visual a las preguntas. Los avances notables comenzaron con modelos como Show and Tell (Google, 2015), que combinaban redes convolucionales con modelos lingüísticos recurrentes. Las investigaciones realizadas en FAIR (Facebook AI Research) y OpenAI hicieron avanzar aún más este campo con arquitecturas que se entrenaban en conjuntos de datos pareados de texto e imágenes a escala.

CLIP (Contrastive Language — Image Pretraining), lanzado por OpenAI en 2021, marcó un punto de inflexión importante. CLIP aprendió conceptos visuales directamente mediante la supervisión del lenguaje natural, lo que le permitió generalizar a una amplia gama de tareas de clasificación de imágenes sin necesidad de realizar ajustes.

Le siguieron DALL·E, Flamingo de DeepMind y, más recientemente, GPT-4 con capacidades de visión.

Estos desarrollos reflejan un cambio de canalizaciones específicas de tareas a modelos de uso general que pueden gestionar múltiples tipos de entrada dentro de un marco unificado.

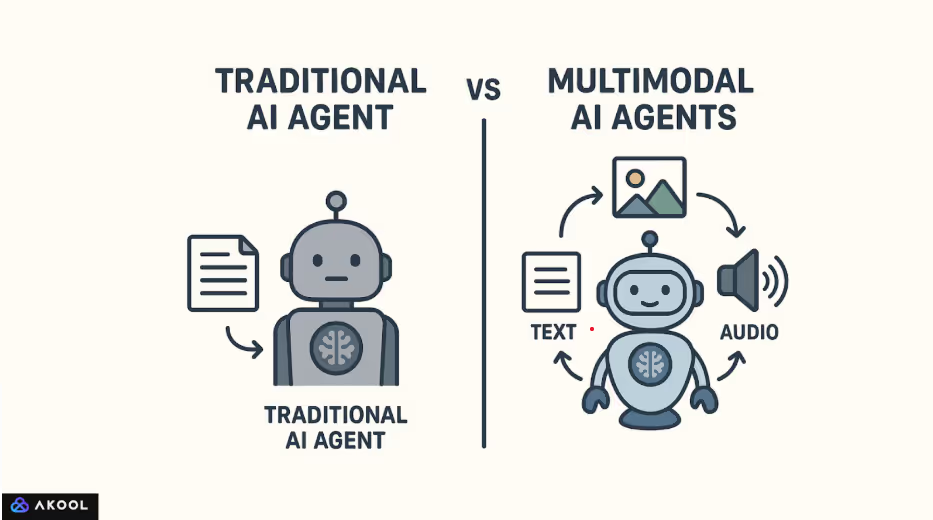

Los modelos de IA tradicionales suelen diseñarse para procesar un único tipo de entrada. Por ejemplo, un modelo de lenguaje como el GPT-2 se entrena solo con texto, mientras que una red neuronal convolucional como ResNet está optimizada para la clasificación de imágenes.

Estos modelos operan dentro de dominios aislados y no pueden interpretar o relacionar de forma natural la información entre diferentes modalidades.

La IA multimodal, por el contrario, está diseñada para procesar y combinar varios tipos de datos en un solo sistema. No trata el texto, las imágenes o el audio como flujos separados, sino que los codifica en un espacio de representación común. Este espacio compartido permite al modelo establecer conexiones entre las modalidades.

Por ejemplo, puede asociar una imagen a un subtítulo, hacer coincidir un sonido con una escena visual o responder al lenguaje hablado con un fotograma de vídeo generado.

Cómo funciona la IA multimodal: componentes técnicos

La IA multimodal funciona al permitir que un único sistema procese, alinee y razone en varios tipos de datos de entrada, como texto, imágenes, audio y vídeo.

En lugar de tratar cada tipo de datos de forma aislada, crea una comprensión compartida al traducir cada modalidad en un formulario que se puede comparar, combinar y utilizar de forma conjunta en las tareas posteriores.

1. Codificación de cada modalidad

El proceso comienza con la codificación de las entradas sin procesar en representaciones estructuradas:

- Texto está codificado mediante modelos de lenguaje basados en transformadores que capturan la semántica y la sintaxis.

- Imagenes se procesan a través de redes neuronales convolucionales o transformadores de visión para extraer características visuales.

- Audio se convierte en espectrogramas o se maneja directamente como formas de onda utilizando codificadores especializados como Wav2Vec o AudioMae.

- Vídeo implica un procesamiento espacial y temporal, a menudo utilizando CNN 3D o mecanismos de atención conscientes del tiempo.

Cada codificador transforma la entrada en un vector de alta dimensión que captura sus características más relevantes.

2. Mapeo a un espacio de representación compartido

Los vectores codificados se proyectan en un espacio latente compartido, donde la información de diferentes modalidades se vuelve comparable. Este espacio se entrena para que el contenido semánticamente similar, como una imagen y su subtítulo, esté muy cerca uno del otro. Los modelos como CLIP logran esto mediante el aprendizaje contrastivo, que reúne a las parejas coincidentes y separa las que no coinciden.

Este espacio compartido es el principal facilitador de la comprensión intermodal. Permite, por ejemplo, que un modelo recupere una imagen basándose en una consulta de texto o genere texto basándose en datos visuales.

3. Alineación y fusión intermodales

Una vez codificada, la información de las diferentes modalidades se integra a través de mecanismos de atención y capas de fusión. Aquí es donde el modelo aprende a alinear las partes relevantes de cada modalidad, por ejemplo, vincular una palabra de una oración con una región específica de una imagen.

Las estrategias de fusión varían según la arquitectura:

- Fusión temprana combina entradas antes de cualquier procesamiento profundo.

- Fusión tardía fusiona las salidas después de que cada modalidad se procese de forma independiente.

- Fusión intermedia (articular) es el más efectivo y de uso común, lo que permite interacciones ricas en varios niveles del modelo.

4. Razonamiento conjunto y generación de resultados

Con representaciones multimodales alineadas, el modelo puede realizar tareas que requieren la comprensión de todos los tipos de entrada en conjunto. Puede generar una descripción textual de una imagen, responder a preguntas sobre un vídeo o llevar a cabo un diálogo oral basado en un contexto visual.

Un decodificador o un cabezal específico para una tarea transforma las representaciones fusionadas en salidas. En modelos multimodales generativos como GPT-4o o Flamingo, el decodificador suele ser un transformador entrenado para producir secuencias de texto, condicionado a entradas tanto lingüísticas como no lingüísticas.

La mayoría de los sistemas multimodales utilizan dos fases:

- Entrenamiento previo: Los conjuntos de datos a gran escala con modalidades pareadas (como imagen-texto o video-texto) se utilizan para aprender representaciones de uso general. Esta fase suele ser autosupervisada.

Puesta a punto: Luego, el modelo se adapta a tareas específicas utilizando conjuntos de datos supervisados más pequeños. Algunos modelos más nuevos admiten directamente el aprendizaje sin o con pocos intentos, sin necesidad de formación adicional.

Obtenga más información sobre medios sintéticos.

Modelados populares de IA multimodal

1. CLIP (lenguaje contrastivo: entrenamiento previo con imágenes) — OpenAI

Lanzado: 2021

Modalidades: Texto e imagen

Características principales:

- Se entrenó con 400 millones de pares de imágenes y texto extraídos de Internet.

- Aprende un espacio de incrustación compartido para imágenes y texto mediante el aprendizaje contrastivo.

- Puede realizar una clasificación de imágenes desde cero haciendo coincidir las incrustaciones de imágenes con las etiquetas de lenguaje natural.

Impacto: Establezca un nuevo estándar para las tareas flexibles del lenguaje visual sin necesidad de realizar ajustes.

2. DALL·E//DALL·E 2 — OpenAI

Lanzado: 2021/2022

Modalidades: Texto a imagen (generativo)

Características principales:

- Genera imágenes a partir de indicaciones en lenguaje natural.

- DALL·E 2 mejoró la resolución, el realismo y las capacidades de edición.

Impacto: Abrió la puerta a las herramientas creativas de inteligencia artificial y mostró cómo el texto puede controlar la generación de imágenes con precisión.

3. Flamingo — DeepMind

Lanzado: 2022

Modalidades: Text, image, video

Características principales:

- Diseñado para el aprendizaje con pocos intentos en tareas multimodales.

- Combina un codificador de visión congelada con un modelo de lenguaje previamente entrenado y capas de atención cruzada.

Impacto: Demostro un buen desempeño en varios puntos de referencia del lenguaje visual con muy poca capacitación específica para cada tarea.

4. Palm-e — Google Research

Lanzado: 2023

Modalidades: Text Input, image, robot sensor

Características principales:

- Integra las entradas de control de robots del mundo real en un modelo de lenguaje amplio (PalM).

- Permite a los robots seguir instrucciones multimodales, como «ir a la cocina y buscar una taza roja».

Impacto: Se mostró cómo los modelos lingüísticos pueden basarse en entornos físicos y agentes encarnados.

5. GPT-4 with Vision (GPT-4V) /GPT-4o — OpenAI

Lanzado: GPT-4V (2023), GPT-4o (2024)

Modalidades: Text, image, audio, video

Características principales:

- GPT-4V introdujo la entrada de imágenes en GPT-4.

- GPT-4o («omni») integra todas las modalidades de forma nativa, incluida la entrada y salida de voz en tiempo real.

- El modelo único procesa y genera en todas las modalidades.

Impacto: Avanza hacia asistentes de IA unificados y en tiempo real con comprensión visual, oral y de texto.

6. Kosmos-1/Kosmos-2 — Microsoft Research

Lanzado: 2023

Modalidades: Texto e imagen

Características principales:

- Combina la visión y el lenguaje a través de una comprensión sólida.

- Kosmos-2 introdujo la base de objetos para el razonamiento espacial.

Impacto: Se centra en la base del conocimiento y en el razonamiento del lenguaje visual para tareas generales de inteligencia.

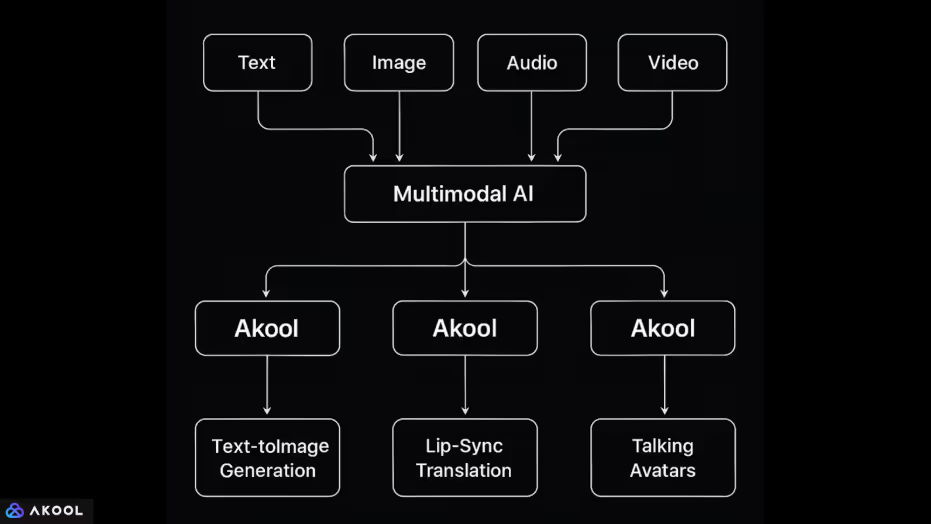

Cómo usar Akool the IA multimodal

Akool es una plataforma que integra múltiples modalidades de datos: texto, imagen, audio y vídeo, en un único entorno impulsado por la IA.

Esta integración le permite realizar tareas multimedia complejas que requieren que el modelo comprenda y genere en diferentes tipos de entrada. Así es como se maneja y combina cada modalidad:

1. Texto + Imagen

- Text to image generation: Los usuarios pueden introducir instrucciones para generar imágenes. Esto requiere que el sistema asigne las entradas del lenguaje natural al contenido visual mediante un espacio de representación compartido, similar a modelos como DALL·E o Stable Diffusion.

- Edición de imágenes mediante instrucciones: Los usuarios pueden modificar las imágenes (cambiar el fondo, la iluminación, la pose, etc.) utilizando un lenguaje natural, lo que demuestra la capacidad del sistema para alinear las instrucciones de texto con las transformaciones visuales.

2. Imagen + Audio + Vídeo

- Intercambio de rostros y animación de avatares: Akool permite a los usuarios animar rostros en fotos mediante entradas de audio o guiones de texto. Esto requiere alinear las marcas faciales de una imagen con la temporización del audio o del texto a nivel del fonema, sincronizando el movimiento y la expresión según las modalidades.

- Tradução com sincronizacion de labios: La plataforma puede traducir el audio hablado a otro idioma y modificar el movimiento de los labios del hablante en vídeo para que coincida con el discurso traducido. Esto combina:

- Conversión de audio a texto (reconocimiento de voz),

- Traducción de textos (procesamiento del lenguaje natural),

- Conversión de texto a audio (síntesis de voz),

- Reprocesamiento de vídeo (edición visual con modelado de movimiento).

- Conversión de audio a texto (reconocimiento de voz),

3. Texto + Audio + Vídeo

- Avatares parlantes: Un usuario puede introducir un guion (texto), que se sintetiza en voz y se anima mediante un avatar virtual. El sistema asigna el texto a la voz y la voz al movimiento facial, combinando la generación de lenguaje natural, la conversión de texto a voz y la animación facial.

- Avatares de IA en vivo: La función de cámara en vivo permite a los usuarios aparecer como avatares en las videoconferencias. Aquí, la entrada de audio en tiempo real (voz) y, posiblemente, la transmisión de vídeo facial (expresión) se asignan a un personaje animado sintético.