يشير الذكاء الاصطناعي متعدد الوسائط إلى الأنظمة التي يمكنها فهم المعلومات وتوليدها عبر أنواع متعددة من البيانات، بما في ذلك النصوص والصور والصوت والفيديو. على عكس نماذج الذكاء الاصطناعي التقليدية التي تعمل بطريقة واحدة، تم تصميم النماذج متعددة الوسائط لمعالجة ودمج المعلومات من عدة مصادر في وقت واحد.

يتيح ذلك تفكيرًا أكثر دقة وتفاعلات أكثر ثراءً وتطبيقًا أوسع عبر مهام العالم الحقيقي.

من قدرة GPT-4 على التعامل مع المدخلات الصوتية والمرئية، إلى التطبيقات في تشخيص الرعاية الصحية، والروبوتات، وتوليد الوسائط، أصبح الذكاء الاصطناعي متعدد الوسائط بسرعة محوريًا لكيفية إدراك الآلات للعالم والاستجابة له.

فهم الذكاء الاصطناعي متعدد الوسائط: التعريف والأساسيات

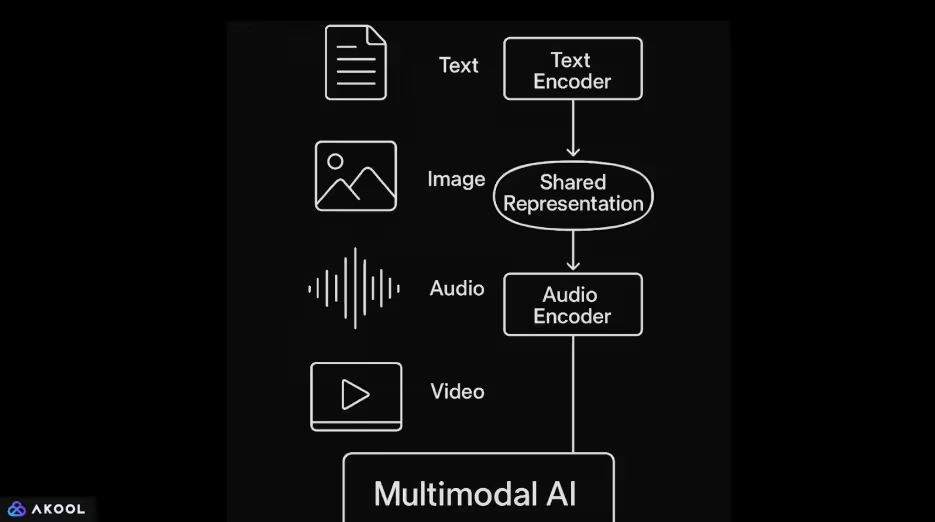

تجمع أنظمة الذكاء الاصطناعي متعددة الوسائط أنواعًا مختلفة من البيانات، مثل النصوص والصور والصوت والفيديو ضمن نموذج واحد. يقوم برنامج التشفير المخصص أولاً بمعالجة كل إدخال. عادةً ما تتعامل نماذج اللغة القائمة على المحول مع النص. تتم معالجة الصور باستخدام الشبكات العصبية التلافيفية أو محولات الرؤية. غالبًا ما يتم ترميز الصوت باستخدام النماذج القائمة على الطيف أو محولات الشكل الموجي.

بمجرد ترميز كل إدخال في تمثيل متجه، يقوم النموذج بتعيين هذه المتجهات في مساحة كامنة مشتركة.

تسمح هذه المساحة المشتركة للنظام بتعلم العلاقات عبر الطرائق. على سبيل المثال، يمكن ربط تسمية توضيحية بصورة أو مطابقة عبارة منطوقة بمحتوى فيديو ذي صلة. غالبًا ما تستخدم آليات الانتباه لمواءمة المعلومات ودمجها عبر هذه المدخلات بطريقة متماسكة.

يتيح الذكاء الاصطناعي متعدد الوسائط مخرجات أكثر مرونة وإدراكًا للسياق. يمكن لنموذج واحد تنفيذ مهام مثل وصف الصور بلغة طبيعية أو الإجابة على أسئلة حول محتوى الفيديو أو إنشاء إجابات بناءً على مزيج من النص والمرئيات.

تعرف على المزيد حول وكلاء الذكاء الاصطناعي متعدد الوسائط.

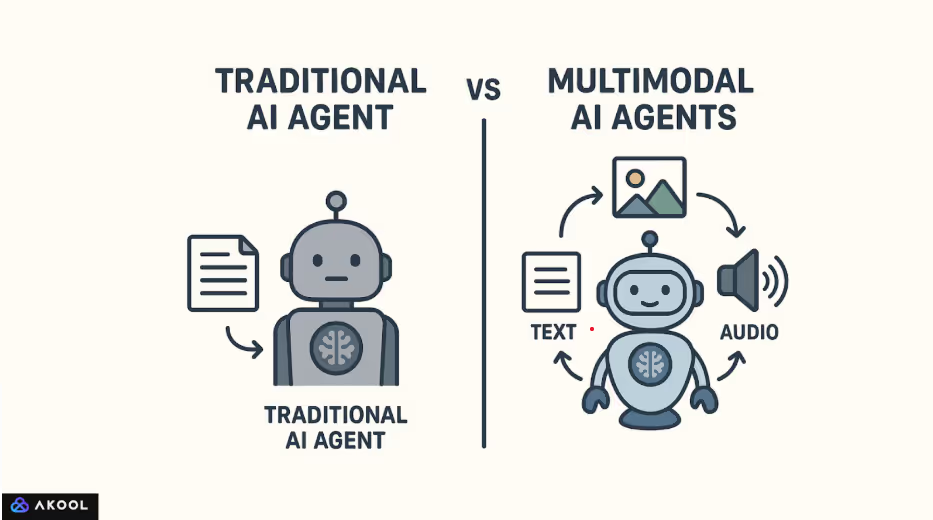

كيف يختلف الذكاء الاصطناعي متعدد الوسائط عن الذكاء الاصطناعي التقليدي

تم وضع الأساس للذكاء الاصطناعي متعدد الوسائط من خلال العمل المبكر في شرح الصور والإجابة المرئية على الأسئلة. بدأ التقدم الملحوظ مع نماذج مثل Show and Tell (Google، 2015)، التي جمعت بين الشبكات التلافيفية ونماذج اللغات المتكررة. أدت الأبحاث في FAIR (Facebook AI Research) و OpenAI إلى تطوير المجال من خلال الهياكل التي تم تدريبها على مجموعات بيانات النص والصور المزدوجة على نطاق واسع.

كان CLIP (اللغة التباينية - التدريب المسبق للصورة)، الذي أصدرته OpenAI في عام 2021، بمثابة نقطة تحول رئيسية. تعلمت CLIP المفاهيم المرئية مباشرة من الإشراف على اللغة الطبيعية، مما سمح لها بالتعميم على مجموعة واسعة من مهام تصنيف الصور دون ضبط دقيق.

وأعقب ذلك DALL·E، وفلامنغو بواسطة DeepMind، ومؤخرًا GPT-4 بقدرات الرؤية.

تعكس هذه التطورات التحول من خطوط الأنابيب الخاصة بالمهام إلى نماذج الأغراض العامة التي يمكنها التعامل مع أنواع المدخلات المتعددة ضمن إطار موحد.

عادةً ما يتم تصميم نماذج الذكاء الاصطناعي التقليدية لمعالجة نوع واحد من المدخلات. على سبيل المثال، يتم تدريب نموذج لغوي مثل GPT-2 على النص فقط، بينما يتم تحسين الشبكة العصبية التلافيفية مثل ResNet لتصنيف الصور.

تعمل هذه النماذج ضمن مجالات معزولة ولا يمكنها بشكل طبيعي تفسير المعلومات أو ربطها عبر طرائق مختلفة.

على النقيض من ذلك، تم تصميم الذكاء الاصطناعي متعدد الوسائط لمعالجة ودمج أنواع متعددة من البيانات داخل نظام واحد. لا يتعامل مع النص أو الصور أو الصوت كتدفقات منفصلة ولكنه بدلاً من ذلك يشفرها في مساحة تمثيلية مشتركة. تسمح هذه المساحة المشتركة للنموذج برسم الروابط بين الطرائق.

على سبيل المثال، يمكن ربط صورة بتعليق، أو مطابقة الصوت بمشهد مرئي، أو الاستجابة للغة المنطوقة باستخدام إطار فيديو تم إنشاؤه.

كيف يعمل الذكاء الاصطناعي متعدد الوسائط: المكونات التقنية

يعمل الذكاء الاصطناعي متعدد الوسائط من خلال تمكين نظام واحد من المعالجة والمواءمة والتفكير عبر أنواع متعددة من بيانات الإدخال، مثل النص والصور والصوت والفيديو.

بدلاً من معالجة كل نوع من أنواع البيانات بشكل منفصل، فإنه يخلق فهمًا مشتركًا من خلال ترجمة كل طريقة إلى نموذج يمكن مقارنته ودمجه واستخدامه بشكل مشترك في المهام النهائية.

1. ترميز كل طريقة

تبدأ العملية بترميز المدخلات الأولية في تمثيلات منظمة:

- النص يتم ترميزه باستخدام نماذج اللغة القائمة على المحولات التي تلتقط الدلالات والنحو.

- صور تتم معالجتها من خلال الشبكات العصبية التلافيفية أو محولات الرؤية لاستخراج الميزات المرئية.

- الصوت يتم تحويلها إلى مخططات طيفية أو التعامل معها مباشرة كأشكال موجة باستخدام أجهزة تشفير متخصصة مثل Wav2Vec أو AudioMae.

- فيديو يتضمن كلاً من المعالجة المكانية والزمانية، وغالبًا باستخدام شبكات CNN ثلاثية الأبعاد أو آليات الانتباه الواعية بالوقت.

يقوم كل برنامج تشفير بتحويل المدخلات إلى متجه عالي الأبعاد يلتقط ميزاته الأكثر صلة.

2. التخطيط إلى مساحة تمثيل مشتركة

يتم عرض المتجهات المشفرة في مساحة كامنة مشتركة، حيث تصبح المعلومات من الطرائق المختلفة قابلة للمقارنة. تم تدريب هذه المساحة بحيث يكون المحتوى المتشابه لغويًا، مثل الصورة والتعليق عليها، قريبًا من بعضهما البعض. تحقق نماذج مثل CLIP ذلك باستخدام التعلم التبادلي، الذي يجمع الأزواج المتطابقة معًا ويدفع الأزواج غير المتطابقة بعيدًا عن بعضها البعض.

هذه المساحة المشتركة هي الممكّن الأساسي للفهم متعدد الوسائط. يسمح، على سبيل المثال، لنموذج باسترداد صورة بناءً على استعلام نصي أو إنشاء نص بناءً على الإدخال المرئي.

3. المحاذاة عبر الوسائط والدمج

بمجرد التشفير، يتم دمج المعلومات من الطرائق المختلفة من خلال آليات الانتباه وطبقات الاندماج. هذا هو المكان الذي يتعلم فيه النموذج محاذاة الأجزاء ذات الصلة من كل طريقة - على سبيل المثال، ربط كلمة في جملة بمنطقة معينة في الصورة.

تختلف استراتيجيات الاندماج حسب البنية:

- الاندماج المبكر يجمع المدخلات قبل أي معالجة عميقة.

- الاندماج المتأخر يدمج المخرجات بعد معالجة كل طريقة بشكل مستقل.

- الاندماج المتوسط (المشترك) هو الأكثر فعالية والأكثر استخدامًا، مما يتيح التفاعلات الغنية على مستويات متعددة من النموذج.

4. التفكير المشترك وتوليد المخرجات

باستخدام التمثيلات متعددة الوسائط المتوافقة، يمكن للنموذج تنفيذ المهام التي تتطلب فهم جميع أنواع المدخلات معًا. يمكنه إنشاء وصف نصي للصورة أو الإجابة على أسئلة حول مقطع فيديو أو إجراء حوار منطوق يرتكز على السياق المرئي.

تقوم وحدة فك الترميز أو الرأس الخاص بالمهمة بتحويل التمثيلات المدمجة إلى مخرجات. في النماذج التوليدية متعددة الوسائط مثل GPT-4o أو Flamingo، تكون وحدة فك الترميز عادةً محولًا مدربًا على إنتاج تسلسلات من النص، مشروطة بكل من المدخلات اللغوية وغير اللغوية.

تستخدم معظم الأنظمة متعددة الوسائط مرحلتين:

- تدريب مسبق: تُستخدم مجموعات البيانات واسعة النطاق ذات الطرائق المزدوجة (مثل نص الصورة أو نص الفيديو) لتعلم تمثيلات الأغراض العامة. غالبًا ما يتم الإشراف على هذه المرحلة ذاتيًا.

الضبط الدقيق: يتم بعد ذلك تكييف النموذج لمهام محددة باستخدام مجموعات بيانات أصغر خاضعة للإشراف. تدعم بعض الموديلات الجديدة التعلم بدون جرعة أو بضع لقطات مباشرة، دون مزيد من التدريب.

تعرف على المزيد حول وسائط اصطناعية.

نماذج الذكاء الاصطناعي متعددة الوسائط الشائعة

1. CLIP (اللغة المتناقضة - التدريب المسبق للصورة) - OpenAI

تم إصداره: 2021

الطرائق: نص وصورة

الميزات الرئيسية:

- تم تدريبه على 400 مليون زوج من الصور والنصوص المأخوذة من الإنترنت.

- يتعرف على مساحة تضمين مشتركة للصور والنصوص باستخدام التعلم المتباين.

- يمكن إجراء تصنيف الصور بدون لقطة عن طريق مطابقة عمليات تضمين الصور مع تسميات اللغة الطبيعية.

التأثير: وضع معيار جديد لمهام لغة الرؤية المرنة دون ضبط دقيق.

2. دال·و/دال·2 — OpenAI

تم إصداره: 2021/2022

الطرائق: نص إلى صورة (توليدي)

الميزات الرئيسية:

- يقوم بإنشاء صور من مطالبات اللغة الطبيعية.

- قامت DALL·E 2 بتحسين الدقة والواقعية وقدرات التحرير.

التأثير: فتح الباب أمام أدوات الذكاء الاصطناعي الإبداعية وأظهر كيف يمكن للنص التحكم في توليد الصور بدقة.

3. فلامنغو - ديب مايند

تم إصداره: 2022

الطرائق: نص، صورة، فيديو

الميزات الرئيسية:

- مصممة للتعلم باستخدام لقطات قليلة في المهام متعددة الوسائط.

- يجمع بين مشفر الرؤية المجمدة ونموذج اللغة الذي تم اختباره مسبقًا وطبقات الانتباه المتبادل.

التأثير: أظهر أداءً قويًا عبر معايير لغة الرؤية المتعددة مع القليل جدًا من التدريب الخاص بالمهام.

4. Palm-e — أبحاث جوجل

تم إصداره: 2023

الطرائق: إدخال النص والصورة ومستشعر الروبوت

الميزات الرئيسية:

- يدمج مدخلات التحكم في الروبوت في العالم الحقيقي في نموذج لغة كبير (PalM).

- تمكن الروبوتات من اتباع التعليمات متعددة الوسائط، مثل «اذهب إلى المطبخ وابحث عن كوب أحمر».

التأثير: أظهر كيف يمكن تأسيس نماذج اللغة في البيئات المادية والعوامل المجسدة.

5. GPT-4 مع الرؤية (GPT-4V) /GPT-4O - OpenAI

تم إصداره: جي بي تي-4V (2023)، جي بي تي-4o (2024)

الطرائق: نص، صورة، صوت، فيديو

الميزات الرئيسية:

- قدم GPT-4V إدخال الصورة إلى GPT-4.

- يدمج GPT-4o («omni») جميع الطرائق محليًا، بما في ذلك الإدخال والإخراج الصوتي في الوقت الفعلي.

- نموذج واحد يعالج ويولد عبر الطرائق.

التأثير: يتجه نحو مساعدي الذكاء الاصطناعي الموحدين في الوقت الفعلي مع فهم الرؤية والكلام والنص.

6. كوزموس 1/كوزموس-2 - أبحاث مايكروسوفت

تم إصداره: 2023

الطرائق: نص وصورة

الميزات الرئيسية:

- يجمع بين الرؤية واللغة من خلال الفهم الراسخ.

- قدم Kosmos-2 أسس الكائن للتفكير المكاني.

التأثير: ركز على أسس المعرفة واستدلال لغة الرؤية لمهام الذكاء العام.

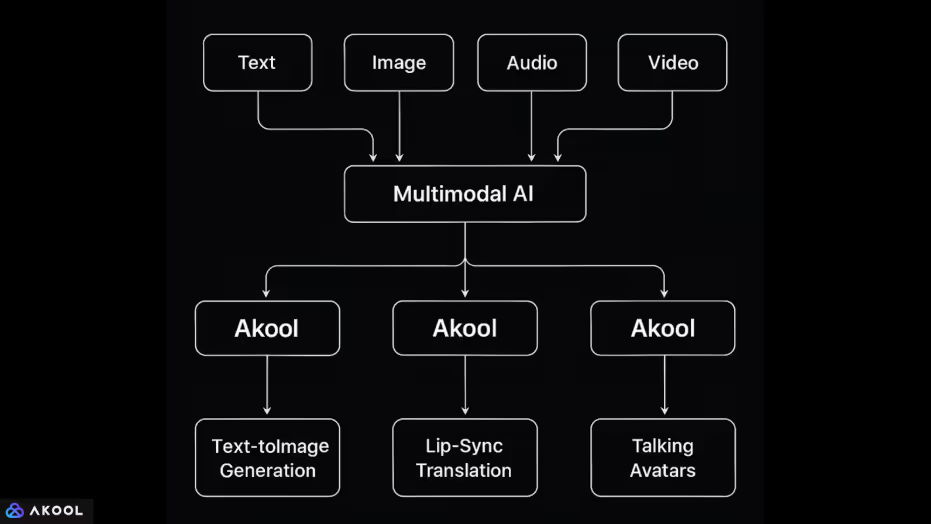

كيف تستخدم Akool الذكاء الاصطناعي متعدد الوسائط

Akool عبارة عن منصة تدمج طرائق بيانات متعددة: النص والصورة والصوت والفيديو، ضمن بيئة واحدة تعتمد على الذكاء الاصطناعي.

يتيح هذا التكامل تنفيذ مهام الوسائط المعقدة التي تتطلب النموذج لفهمها وتوليدها عبر أنواع الإدخال المختلفة. فيما يلي كيفية التعامل مع كل طريقة ودمجها:

1. نص + صورة

- توليد نص إلى صورة: يمكن للمستخدمين إدخال المطالبات لإنشاء الصور. يتطلب هذا من النظام تعيين مدخلات اللغة الطبيعية للمحتوى المرئي باستخدام مساحة تمثيل مشتركة، على غرار نماذج مثل DALL·E أو Stable Diffusion.

- تحرير الصور عبر المطالبات: يمكن للمستخدمين تعديل الصور (تغيير الخلفية والإضاءة والوضع وما إلى ذلك) باستخدام اللغة الطبيعية، مما يدل على قدرة النظام على مواءمة التعليمات النصية مع التحولات المرئية.

2. صورة + صوت + فيديو

- تبديل الوجه والرسوم المتحركة للأفاتار: يتيح Akool للمستخدمين تحريك الوجوه في الصور باستخدام إدخال الصوت أو البرامج النصية. يتطلب ذلك محاذاة معالم الوجه من الصورة مع التوقيت الصوتي أو النصي على مستوى الصوت، ومزامنة الحركة والتعبير عبر الطرائق.

- ترجمة ليب-سينك: يمكن للمنصة ترجمة الصوت المنطوق إلى لغة أخرى وتعديل حركة شفاه المتحدث في الفيديو لتتناسب مع الكلام المترجم. هذا يجمع بين:

- تحويل الصوت إلى نص (التعرف على الكلام)،

- ترجمة النص (معالجة اللغة الطبيعية)،

- تحويل النص إلى صوت (تركيب الكلام)،

- إعادة عرض الفيديو (التحرير المرئي مع نمذجة الحركة).

- تحويل الصوت إلى نص (التعرف على الكلام)،

3. نص + صوت + فيديو

- الصور الرمزية الناطقة: يمكن للمستخدم إدخال برنامج نصي (نص)، يتم تصنيعه في شكل كلام وتحريكه باستخدام صورة رمزية افتراضية. يقوم النظام بتعيين النص إلى الصوت والصوت إلى حركة الوجه، ويمزج بين توليد اللغة الطبيعية وتحويل النص إلى كلام والرسوم المتحركة للوجه.

- صور رمزية حية للذكاء الاصطناعي: تتيح ميزة Live Camera للمستخدمين الظهور كصور رمزية في اجتماعات الفيديو. هنا، يتم تعيين إدخال الصوت في الوقت الفعلي (الكلام) وربما تغذية فيديو الوجه (التعبير) إلى شخصية متحركة اصطناعية.