多模态人工智能是指能够理解多种类型数据(包括文本、图像、音频和视频)并生成信息的系统。与使用单一模态的传统 AI 模型不同,多模态模型旨在同时处理和整合来自多个来源的信息。

这样可以实现更准确的推理、更丰富的交互以及在现实任务中的更广泛应用。

从 GPT-4 处理语音和视觉输入的能力,到医疗诊断、机器人和媒体生成方面的应用,多模态人工智能正迅速成为机器感知和响应世界的核心。

了解多模态人工智能:定义和基础知识

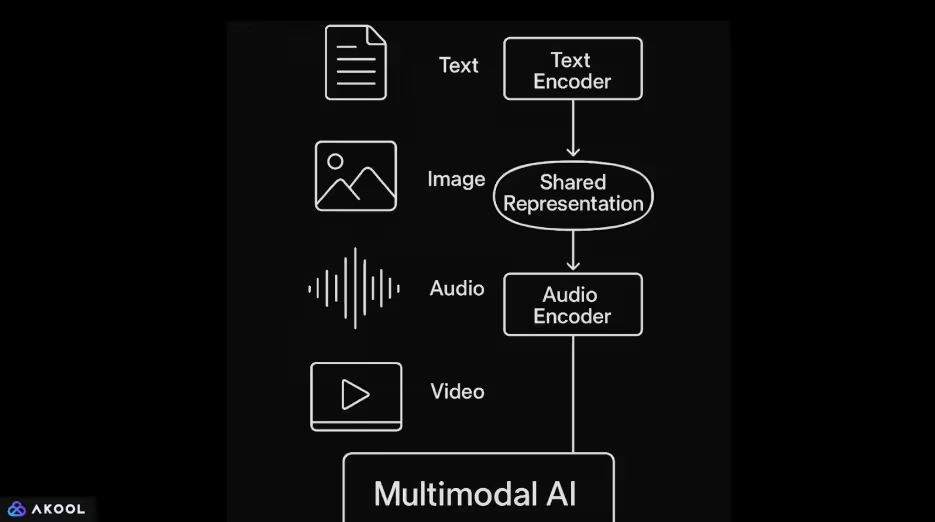

多模式 AI 系统将不同类型的数据(例如文本、图像、音频和视频)组合到一个模型中。专用的编码器首先处理每个输入。基于 Transformer 的语言模型通常处理文本。图像使用卷积神经网络或视觉转换器进行处理。音频通常使用基于频谱图的模型或波形变压器进行编码。

将每个输入编码为矢量表示后,模型将这些向量映射到共享的潜在空间。

这种共享空间使系统能够学习各种模式之间的关系。例如,它可以将标题链接到图像或将口语与相关的视频内容进行匹配。注意力机制通常用于协调和整合这些输入中的信息。

多模态人工智能支持更灵活的情境感知输出。单一模型可以执行诸如用自然语言描述图像、回答有关视频内容的问题或根据文本和视觉效果的组合生成响应等任务。

了解更多关于 多模式 AI 代理。

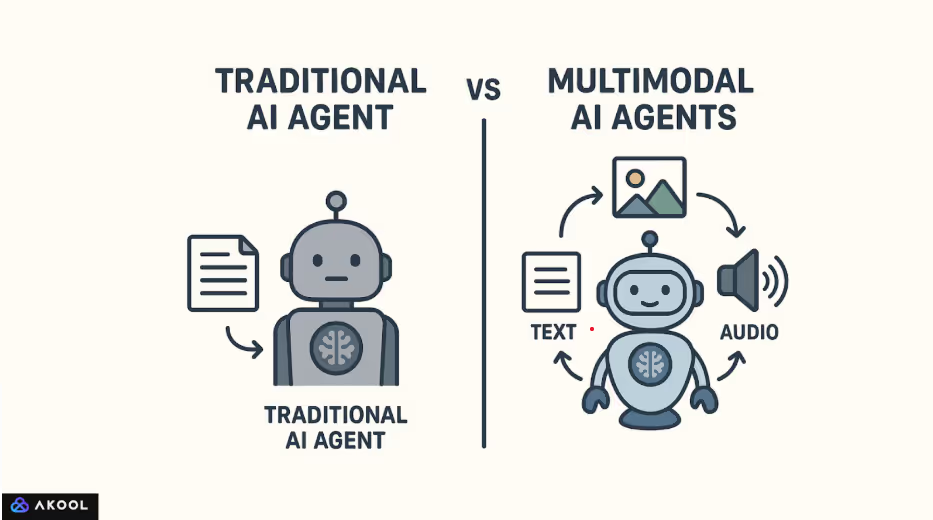

多模态人工智能与传统 AI 有何不同

多模态人工智能的基础是由图像字幕和视觉问答方面的早期工作奠定的。显著的进展始于Show and Tell(谷歌,2015年)等模型,这些模型将卷积网络与循环语言模型相结合。FAIR(Facebook AI Research)和OpenAI的研究进一步推动了该领域的发展,这些架构是在成对的文本图像数据集上大规模训练的。

OpenAI 于 2021 年发布的 CLIP(对比语言——图像预训练)标志着一个重大的转折点。CLIP 直接从自然语言监督中学习视觉概念,使其无需微调即可推广到各种图像分类任务。

紧随其后的是 DALL·E、DeepMind 的 Flamingo,最近还有具有视觉功能的 GPT-4。

这些发展反映了从特定任务流水线向可以在统一框架内处理多种输入类型的通用模型的转变。

传统的人工智能模型通常设计为处理单一类型的输入。例如,像 GPT-2 这样的语言模型只能在文本上训练,而像 ResNet 这样的卷积神经网络则针对图像分类进行了优化。

这些模型在孤立的领域内运行,无法自然地解释或关联不同模式下的信息。

相比之下,多模态人工智能旨在在一个系统中处理和组合多种类型的数据。它不将文本、图像或音频视为单独的流,而是将它们编码到一个共同的表示空间中。这种共享空间允许模型在模态之间建立联系。

例如,它可以将图像与标题关联,将声音与视觉场景进行匹配,或者使用生成的视频帧来回应口语。

多模态人工智能的工作原理:技术组件

多模态人工智能的工作原理是使单个系统能够处理、调整和推理多种类型的输入数据,例如文本、图像、音频和视频。

它不是孤立地对待每种数据类型,而是通过将每种模式转换为可在下游任务中进行比较、组合和联合使用的形式来建立共识。

1。对每种模式进行编码

该过程首先将原始输入编码为结构化表示:

- 文本 使用基于转换器的语言模型进行编码,该模型捕获语义和语法。

- 图片 通过卷积神经网络或视觉转换器进行处理,以提取视觉特征。

- 音频 使用 Wav2Vec 或 AudioMAE 等专用编码器转换为频谱图或直接作为波形进行处理。

- 视频 涉及空间和时间处理,通常使用 3D CNN 或时间感知注意力机制。

每个编码器将输入转换为捕获其最相关的特征的高维矢量。

2。映射到共享表示空间

编码后的向量被投射到一个共享的潜在空间中,来自不同模式的信息变得可比。该空间经过训练,可以使语义相似的内容(例如图像及其标题)紧密相连。像CLIP这样的模型通过使用对比学习来实现这一点,它将匹配的对拉到一起,并将不匹配的配对分开。

这个共享空间是跨模式理解的核心推动力。例如,它允许模型根据文本查询检索图像或根据视觉输入生成文本。

3.跨模态校准和融合

编码后,来自不同模式的信息就会通过注意力机制和融合层进行整合。在这里,模型学会对齐每种模态的相关部分,例如,将句子中的单词与图像中的特定区域联系起来。

融合策略因架构而异:

- 早期融合 在进行任何深度处理之前合并输入。

- 晚期融合 在独立处理每种模态后合并输出。

- 中级(关节)融合 是最有效和最常用的,可以在模型的多个级别上进行丰富的交互。

4。联合推理和产出生成

通过对齐的多模态表示,该模型可以执行需要共同了解所有输入类型的任务。它可以生成图像的文字描述,回答有关视频的问题,或者进行基于视觉环境的口语对话。

解码器或特定任务头部将融合的表示形式转换为输出。在 GPT-4o 或 Flamingo 等生成式多模态模型中,解码器通常是经过训练的转换器,可以根据语言和非语言输入生成文本序列。

大多数多式联运系统使用两个阶段:

- 预训练:使用具有成对模式(例如图像文本或视频文本)的大型数据集来学习通用表示。这个阶段通常是自我监督的。

微调:然后使用较小的监督数据集对模型进行调整以适应特定任务。一些较新的模型直接支持零样本或少量学习,无需进一步训练。

了解更多关于 合成媒体。

流行的多模态 AI 模型

1。CLIP(对比语言——图像预训练)— OpenAI

已发布: 2021

模式: 文字和图片

主要特征:

- 对从互联网上抓取的4亿对图像文本进行了训练。

- 使用对比学习来学习图像和文本的共享嵌入空间。

- 可以通过将图像嵌入与自然语言标签进行匹配来执行零镜头图像分类。

冲击:无需微调即可为灵活的视觉语言任务设定新标准。

2。DALL·E/DALL·E 2 — OpenAI

已发布: 2021/2022

模式: 文本到图像(生成式)

主要特征:

- 根据自然语言提示生成图像。

- DALL·E 2 提高了分辨率、真实感和编辑功能。

冲击: 打开了创造性人工智能工具的大门,并展示了文本如何精确控制图像生成。

3.火烈鸟 — DeepMind

已发布: 2022

模式: 文本、图片、视频

主要特征:

- 专为多模态任务的少镜头学习而设计。

- 将冻结视觉编码器与预训练的语言模型和交叉注意力层相结合。

冲击: 只需很少的任务特定训练,即可在多个视觉语言基准测试中表现出强劲的表现。

4。Palm-e — 谷歌研究

已发布: 2023

模式: 文本、图像、机器人传感器输入

主要特征:

- 将真实世界的机器人控制输入嵌入到大型语言模型 (PaLM) 中。

- 使机器人能够遵循多模式指令,例如 “去厨房找一个红色的马克杯”。

冲击: 展示了如何将语言模型建立在物理环境和具体代理的基础上。

5。带视觉功能的 GPT-4 (GPT-4V)/GPT-4O — OpenAI

已发布: GPT-4V (2023)、GPT-4o (2024)

模式: 文本、图像、音频、视频

主要特征:

- GPT-4V 向 GPT-4 引入了图像输入。

- GPT-4o(“omni”)原生集成了所有模式,包括实时语音输入和输出。

- 单一模型跨模式处理和生成。

冲击:向具有视觉、语音和文本理解功能的实时、统一的人工智能助手迈进。

6。Kosmos-1/Kosmos-2 — 微软研究

已发布: 2023

模式: 文字和图片

主要特征:

- 通过扎实的理解将视觉和语言相结合。

- Kosmos-2 引入了用于空间推理的对象基础。

冲击: 专注于一般情报任务的知识基础和视觉语言推理。

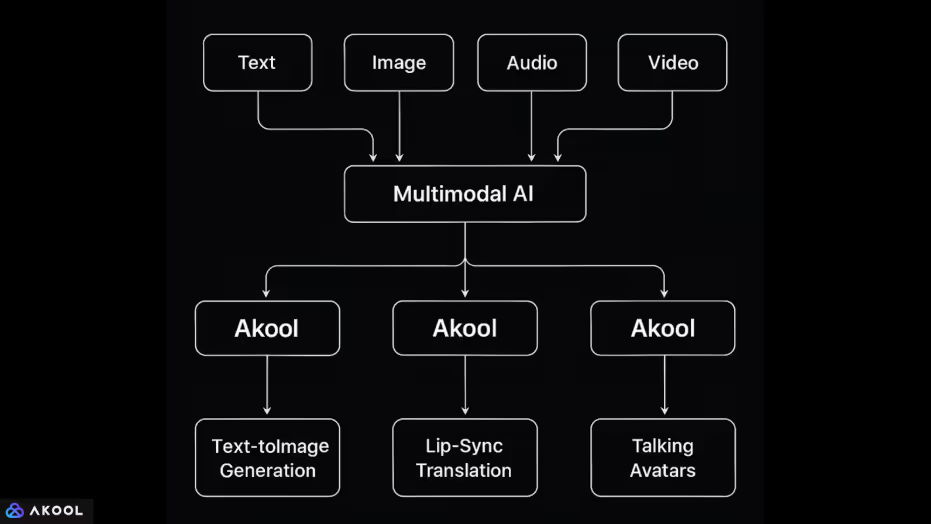

Akool 如何使用多模态 AI

Akool 是一个在单一的人工智能驱动环境中集成了多种数据模式的平台:文本、图像、音频和视频。

这种集成允许它执行复杂的媒体任务,这些任务需要模型理解和生成不同的输入类型。以下是每种模式的处理和组合方式:

1。文本 + 图片

- 文本到图像的生成:用户可以输入提示来生成图像。这要求系统使用共享的表示空间将自然语言输入映射到视觉内容,类似于 DALL·E 或 Stable Diffusion 等模型。

- 通过提示编辑图像:用户可以使用自然语言修改图像(更改背景、灯光、姿势等),这表明系统能够将文本指令与视觉转换保持一致。

2。图像 + 音频 + 视频

- 换脸和头像动画:Akool 使用户能够使用音频输入或文本脚本对照片中的人脸进行动画处理。这需要将图像中的面部地标与音素级音频或文本时序对齐,同步不同模式的动作和表情。

- 口型同步翻译:该平台可以将口语音频翻译成另一种语言,并修改说话者在视频中的唇部动作以匹配翻译后的语音。这结合了:

- 音频转文本(语音识别),

- 文本翻译(自然语言处理),

- 文本转音频(语音合成),

- 视频重新渲染(使用运动建模进行可视化编辑)。

- 音频转文本(语音识别),

3.文本 + 音频 + 视频

- 会说话的头像:用户可以输入脚本(文本),该脚本会合成语音并使用虚拟头像进行动画处理。该系统将文本映射到语音,将语音映射到面部动作,融合了自然语言生成、文字转语音和面部动画。

- 直播 AI 头像:实时摄像机功能允许用户在视频会议中以头像的形式出现。在这里,实时音频输入(语音)以及可能的面部视频源(表情)都映射到合成动画角色。