Einführung: Was kommt als Nächstes für Seedance 1.5?

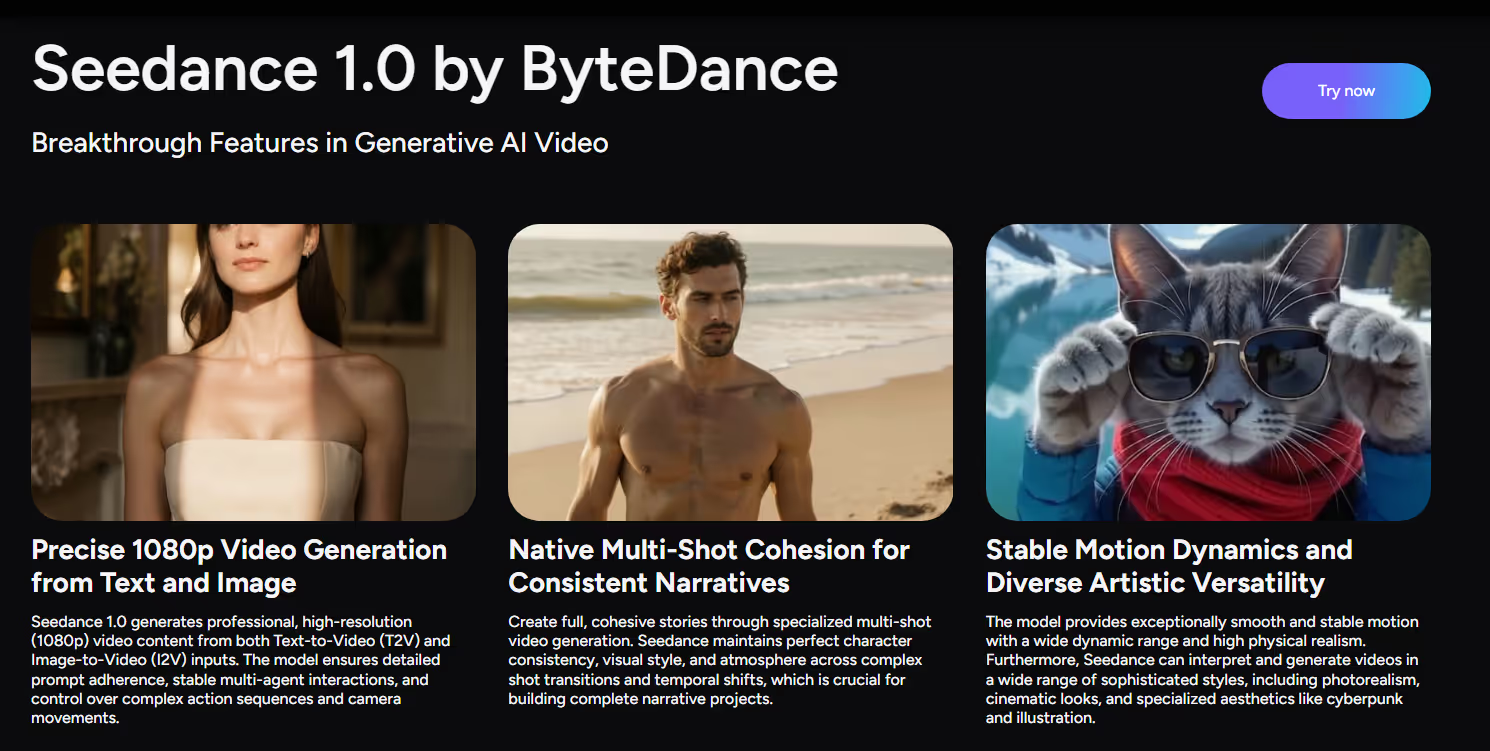

Seedance hat sich schnell zu einem der am meisten diskutierten Namen in KI-Videogenerierung. Die aktuelle Seedance 1.0-Familie unterstützt bereits Video mit mehreren Aufnahmen Sowohl von Text- als auch von Bildeingaben aus und liefern 1080p-Clips mit flüssiger Bewegung, starkem semantischem Verständnis und beeindruckender Prompt-Follower-Funktionalität. Kurz gesagt, Seedance ist heute schnell und qualitativ hochwertig KI-Videogenerator gebaut für das filmische Geschichtenerzählen in Kurzform.

Die nächste Entwicklung dieser Linie wurde noch nicht offiziell veröffentlicht, aber aufgrund des vorhandenen technischen Berichts von Seedance und der breiteren Ausrichtung der Video-Foundation-Modelle ist davon auszugehen, dass die kommenden Seedance 1.5 AI-Videomodell geht über längere und glattere Clips hinaus. Zwei besonders spannende Bereiche für YouTuber dürften sein:

- Audiovisuelle Synchronisation — gemeinsames Generieren von Video und Ton

- Videoreferenz — Verwendung von vorhandenem Filmmaterial zur Steuerung von Bewegung, Stil oder Kontinuität

In dieser Vorschau werden wir untersuchen, was Entwickler von der nächsten Generation von Seedance erwarten können: vorhergesagte Hauptfunktionen und praktische Anwendungsfälle, wobei wir die heutigen Seedance-Funktionen als Startrampe nutzen.

Was YouTuber erwarten können (vorhergesagt)

Wichtig: Die folgenden Funktionen sind prädiktiv und wurden aus der aktuellen Seedance 1.0-Dokumentation und Branchentrends extrapoliert. Sie sind noch nicht offiziell angekündigt.

1. Längeres, kohärenteres Storytelling mit mehreren Aufnahmen

Seedance 1.0 zeichnet sich bereits aus durch Erzählkohärenz mit mehreren Aufnahmen, mit nahtlosen Übergängen und konsistenten Motiven bei allen Aufnahmen.

Das kommende Modell wird wahrscheinlich:

- Unterstützung längere Multi-Shot-Sequenzen als die aktuellen Standardwerte von 5—10 s

- Verbessern Sie die zeitliche Stabilität und reduzieren Sie das Flimmern bei längeren Clips

- Sorgen Sie für einen klareren Storyfluss in mehreren Schnitten und Szenen

Für YouTuber bedeutet das mehr Platz für komplette Mini-Storys, Mehrszenen-Werbespots und kurze Erzählbögen in einem einzigen. KI-Videogenerierung bestehen.

2. Intelligentere Steuerung von Text zu Video und Bild zu Video

Der heutige Seedance unterstützt beide Text zu Video (T2V) und Bild-zu-Video (I2V), sodass YouTuber Szenen aus Eingabeaufforderungen oder Standbildern mit bis zu 1080p animieren können.

Das nächste Modell wird dies wahrscheinlich verbessern mit:

- Besserer Umgang mit komplexe, mehrstufige Eingabeaufforderungen („Drei Aufnahmen: Weites Stadtbild, dann Charakter aus der Nähe, dann Produktheld“)

- Präziser Sprache der Kamera Steuerung: Nahaufnahmen, Tracking-Aufnahmen, Handheld, langsames Zoomen

- Engere Integration von Bildreferenzen für Stil-, Layout- und Zeichensteuerung

Dies würde die nächste Seedance-Veröffentlichung ausdrucksvoller machen KI von Text zu Video und Bild-zu-Video-KI für Kreative, die ihre schriftlichen Anweisungen direkt den Kamerabewegungen und der Bildkomposition zuordnen möchten.

3. Audiovisuelle Synchronisation (vorhergesagt)

Eine wichtige Herausforderung für das nächste Seedance-Modell ist wahrscheinlich audiovisuelle Synchronisation.

Seedance 1.0 löst bereits visuelle Herausforderungen — Kohärenz mehrerer Aufnahmen, stabile Bewegung und schnelles Rendern —, aber es gibt stille Clips aus. Der logische nächste Schritt, der den Trends in anderen Fundamentmodellen entspricht, ist ein KI-Videomodell das kann generieren:

- Gesprochene Erzählung oder Dialog

- Umgebungsgeräusche (Straßenlärm, Natur, Innenräume)

- Soundeffekte, die auf die Ereignisse auf dem Bildschirm abgestimmt sind

- Einfache Musik oder Klangbetten

alles mit dem Video synchronisiert in einem einzigen Durchgang.

Wenn die audiovisuelle Synchronisation in der nächsten Seedance-Version verfügbar ist, könnten die Entwickler:

- Generieren Sie Videos, die für soziale Netzwerke geeignet sind, mit integriertem Sound, anstatt Audio separat zu bearbeiten

- Produziere Clips im Erklärstil mit KI-Voiceover und Bewegung

- Erstellen Sie Prototypen von Story-Ideen, bei denen sich Tempo, Grafik und Sound gemeinsam entwickeln

Das würde Seedance aus einem Stummen machen KI-Videogenerator in eine vollständigere Erstellung von KI-Videos System.

4. Video-Referenz für Bewegung und Stil (vorhergesagt)

Ein weiteres wahrscheinliches Upgrade ist Videoreferenz Unterstützung: Die Möglichkeit, kurze Referenzvideos in das Modell einzuspeisen und von ihnen die Bewegung, den Stil oder die Struktur neuer Clips leiten zu lassen.

Aufbauend auf den bestehenden Stärken von Seedance in den Bereichen Storytelling und Bildführung mit mehreren Aufnahmen könnten Videoreferenzen den Machern Folgendes ermöglichen:

- Verwende einen Live-Action-Clip als Vorlage für Kamerabewegungen und Timing

- Bewegungsmuster (z. B. einen Gehzyklus, Kameraschwenk oder Actionbeat) in eine neu generierte Szene übertragen

- Sorgen Sie für ein konsistentes Framing und Tempo bei mehreren KI-generierten Varianten einer Sequenz

Für KI-Videogenerierung, Videoreferenzen wären ein leistungsstarkes Werkzeug, um eine Brücke zwischen traditionellem Filmmaterial und vollsynthetischen Inhalten zu schlagen — besonders hilfreich bei Konzepten, Vorschauen und stilistischen Experimenten.

5. Noch schnellere und effizientere KI-Videogenerierung

Aus dem technischen Bericht von Seedance geht hervor, dass die Geschwindigkeit gegenüber vielen Wettbewerbern dank der mehrstufigen Destillation und der Optimierung auf Systemebene um das Zehnfache gestiegen ist.

Es ist vernünftig zu erwarten, dass das nächste Modell:

- Beibehalten oder verbessern Hochgeschwindigkeits-Inferenz

- Bieten Sie mehr Kontrolle über Qualität und Geschwindigkeit an (z. B. „Fast Draft“ im Vergleich zu „Cinematic Render“)

- Unterstützt eine höhere Parallelität für große Mengen KI-Videogenerator Arbeitsbelastungen

Für Entwickler und Teams bedeutet das mehr Iterationen in kürzerer Zeit — ideal zum Testen von Hooks, Story-Variationen oder visuellen Anweisungen.

Wie Entwickler das nächste Seedance 1.5-Modell verwenden könnten

Sobald das nächste Seedance-Modell mit diesen erwarteten Upgrades auf den Markt kommt, erfahren Sie hier, wie diese Funktionen in die Realität umgesetzt werden könnten Erstellung von KI-Videos Arbeitsabläufe.

1. Soziale Netzwerke und Kampagnenvideos mit integriertem Sound

Mit vorhergesagten audiovisuelle Synchronisation, Entwickler könnten Seedance verwenden, um:

- Generieren Sie TikTok-/Reels/Kurzfilme, bei denen Bild und Ton zusammenkommen

- Produzieren Sie Werbeclips, in denen Produktaufnahmen, Bewegungs- und Audiohinweise aufeinander abgestimmt sind

- Testen Sie schnell verschiedene Erzähl- und Audiokombinationen, ohne einen vollständigen Bearbeitungsdurchgang durchführen zu müssen

Das macht KI von Text zu Video eher „veröffentlichungsbereit“ für Sound-On-Plattformen.

2. Bewegung und Stil, die auf Videoreferenzen basieren

Wenn Videoreferenz wird unterstützt, das nächste Seedance-Modell könnte ideal sein für:

- Nachahmen des Tempos und der Kamerabewegungen einer Referenzanzeige oder eines Teasers

- Übersetzung eines groben Storyboards oder eines Testshootings in eine ausgefeilte, KI-generierte Version

- Bewegung und Timing konsistent halten, während Stil, Schauplatz oder Charaktere geändert werden

Für Kreative bietet dies eine Brücke zwischen manuellem Fotografieren und vollsynthetischem Seedance KI-Video, wodurch hybride Workflows ermöglicht werden.

3. Storyboards mit mehreren Aufnahmen und Konzept-Trailer

Mit längeren, kohärenteren Multi-Shot-Erzählungen und einer stärkeren T2V/I2V-Kontrolle könnte Seedance helfen:

- Verwandeln Sie Drehbuchausschnitte in schnelle Video-Storyboards

- Erstellen Sie Konzepttrailer für Produkte, Spiele oder Filme

- Entdecke verschiedene visuelle Stile für dieselben Story-Beats

Dies senkt die Barriere, komplexe Ideen visuell zu untersuchen, bevor die Produktion in Angriff genommen wird.

4. Bewegung von Bild zu Video für Demos und Erklärvideos

Verwendung von Enhanced Bild-zu-Video-KI und mögliche Audiosynchronisierung, das nächste Seedance-Modell wäre gut geeignet für:

- Animieren von Produkt-Renderings in Erklärclips mit Erzählung

- Erwecken Sie UI-Mockups mit geführten Kamerabewegungen und Klickabläufen zum Leben

- Verwandeln Sie Charaktergrafiken in Bewegungstests mit synchronisierten Sound-Hinweisen

Diese Workflows helfen Teams, schnell von statischen Designs zu dynamischen Präsentationen überzugehen.

Fazit

Die nächste Generation von Seedance 1.5 KI-Video wurde noch nicht offiziell veröffentlicht, aber die Roadmap lässt sich leicht aus den Stärken von Seedance 1.0 ableiten: cineastisches 1080p Text zu Video und Bild-zu-Video, kohärente Erzählweise mit mehreren Aufnahmen und schnell, effizient KI-Videogenerierung.

Mit Blick auf die Zukunft können YouTuber vernünftigerweise Folgendes erwarten:

- Längere, kohärentere Geschichten mit mehreren Aufnahmen

- Intelligentere Steuerung über Eingabeaufforderungen, Kamerasprache und visuelle Stile

- Audiovisuelle Synchronisation für nativen Sound, Stimme und Effekte (vorhergesagt)

- Videoreferenz um Bewegung und Stil anhand vorhandener Aufnahmen zu steuern (vorhergesagt)

- Hochgeschwindigkeitsinferenz das hält die Iterationszyklen schnell

Während wir auf eine offizielle Ankündigung warten, ist die beste Vorbereitung, zu erkunden, was Seedance heute schon macht: Multi-Shot, cineastisch Erstellung von KI-Videos aus Text und Bildern. Auf diese Weise sind Sie bereit, das Modell der nächsten Generation in Ihren Arbeitsablauf zu integrieren, sobald es verfügbar ist.

Behalte die offiziellen Seed- und Seedance-Kanäle für Release-Updates im Auge — und mach dich bereit, mit audiosynchronisiertem, referenzbasiertem Seedance KI-Video-Storytelling zu experimentieren, wenn das neue Modell live geht.