Einführung in WAN 2.6

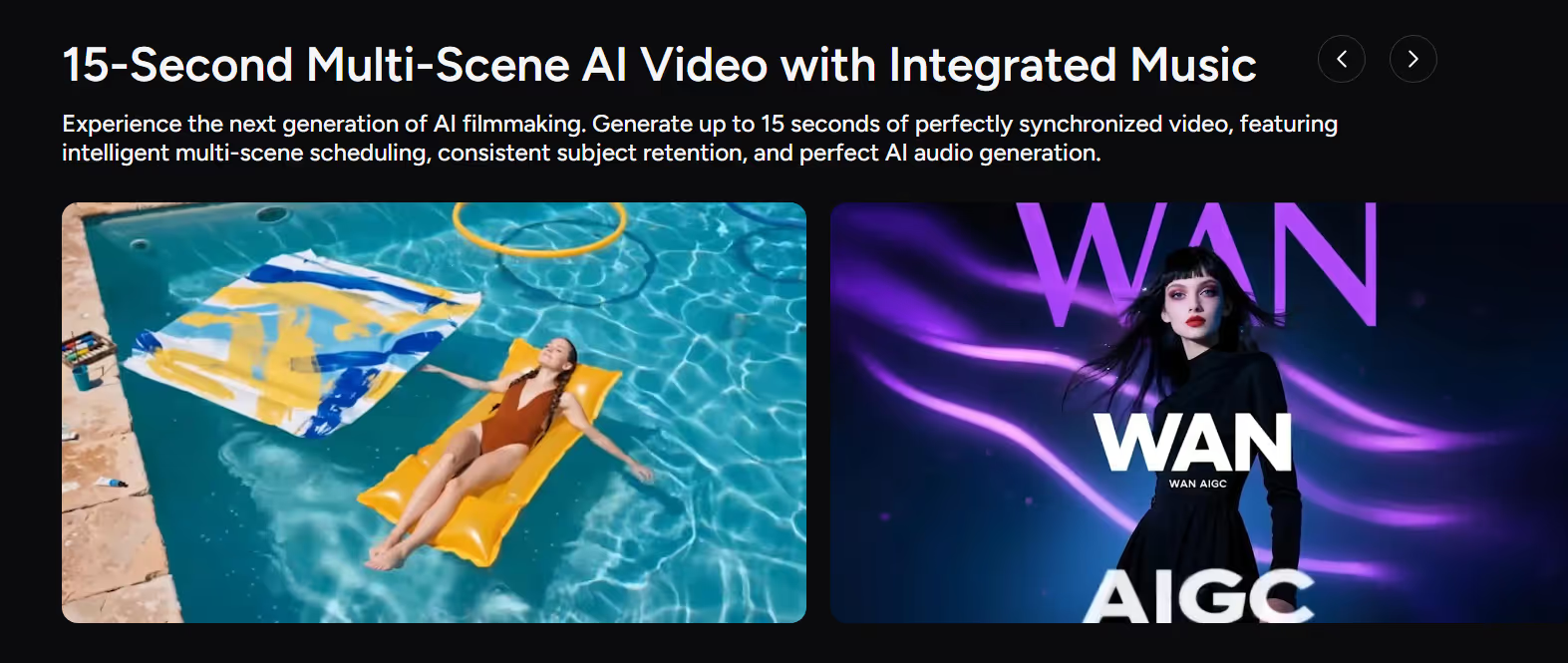

Alibabas WAN Die Serie hat sich schnell zu einer der führenden Familien von entwickelt KI-Videomodelle, bekannt für filmische Bilder, starke Bewegungssteuerung und multimodale Generierung. Mit WAN 2,6, das Modell macht einen großen Schritt vorwärts: Es führt 15-Sekunden-Video mit mehreren Szenen, natives Audio und intelligentere Erzählsteuerung, die direkt auf professionelle Kurzvideos und kommerzielle Inhalte abzielt.

WAN 2.6 ist in Alibaba Cloud Model Studio als beides verfügbar Text zu Video (wan2.6‑t2v) und Bild-zu-Video (wan2.6‑i2v), unterstützt 720p- und 1080p-Renderings mit automatisches Voiceover und benutzerdefinierter Audioimport.

Auf Ein Kool, WAN 2.6 ist jetzt als Feature vollständig integriert KI-Videogenerator, bietet Entwicklern eine einfache Oberfläche zum Generieren 15-Sekunden-KI-Video mit mehreren Szenen mit integrierter Musik, konsistenten Motiven und Kinobewegungen aus Eingabeaufforderungen, Bildern und Audio.

Hauptfunktionen und wichtige Upgrades von WAN 2.6

1. 15-Sekunden-Kinovideo mit mehreren Szenen

Das sichtbarste Upgrade in WAN 2.6 KI-Video ist seine Unterstützung für bis zu 15 Sekunden von qualitativ hochwertigem Video in einer einzigen Generation.

Die wichtigsten Vorteile:

- Erzählsteuerung in mehreren Szenen — Plant automatisch und wechselt automatisch zwischen den Aufnahmen, sodass einfache Handlungsstränge innerhalb eines Clips möglich sind.

- Konsistente Motive in allen Szenen — Behält Charakteren oder Objekten durch Szenenwechsel die gleiche Identität bei, ideal für Storytelling und Produktvideos.

- Kinoqualität bei 720p/1080p — Konzipiert für den professionellen Einsatz in kurzen Inhalten, Anzeigen und Trailern.

Für YouTuber bedeutet das, dass WAN 2.6 nicht mehr nur eine „coole Kurzclips“ -Engine ist — es kann Mini-Story-Beats in einem Durchgang liefern.

2. Natives Audio, automatisches Voiceover und KI-Musik

WAN 2,6 ist ein voll audiovisuelles KI-Videomodell, nicht nur ein leiser Generator.

Aus den Alibaba Cloud-Dokumenten, sowohl wan2.6‑t2v als auch wan2.6‑i2v unterstützt automatisches Voiceover und den Import von benutzerdefinierten Audiodateien, wodurch Dialoge, Erzählungen und Musik mit dem generierten Video synchronisiert werden können.

Auf Akool geht WAN 2.6 noch weiter mit:

- KI-Musikgenerierung — Erstelle originale, lizenzfreie Hintergrundmusik und komplette Songs anhand von Texteingaben, die eng mit dem Video synchronisiert sind.

- Mehrsprachiges Audio — Generieren Sie verschiedene Gesangsstile für Erzähl- oder Charakterstimmen.

- Sprache‑zu‑Video — Verwende Audio, um die Lippensynchronisation und die Gesichtsdarstellung zu verbessern und aus einem Standbild eine sprechende, handelnde Figur zu machen.

Diese native Audiounterstützung macht WAN 2.6 KI-Videogenerierung viel näher an einem fertigen Asset — besonders nützlich für soziale Medien, Marketingvideos und kurze Erläuterungen.

3. Referenzgesteuertes Text-zu-Video und Bild-zu-Video

WAN 2.6 basiert auf referenzgesteuerte Steuerung:

- Bildverweis — Sie können ein Referenzbild hochladen, um Charakter, Stil oder Produktlook zu bestimmen, während WAN 2.6 Bewegungen und Szenen rund um das Bild generiert.

- Videoreferenz und „mit allem, was die Hauptrolle spielt“ — Wan 2.6 von Tongyi unterstützt die Generierung von Videoreferenzen, bei der jede Person oder jedes Objekt in einem Referenzvideo zum Hauptdarsteller in einem neuen KI-Video werden kann.

Auf Akool wird das wie folgt angezeigt:

- Referenzbild und erweiterte Text-zu-Video‑Technologie — Kombinieren Sie Eingabeaufforderung und Referenz, um Ästhetik, Kamerastil und Subjektidentität zu steuern.

Das macht WAN 2.6 ideal für Kreative, die eine genaue Kontrolle über das Aussehen und das Feel haben möchten und gleichzeitig von schnellen Text zu Video und Bild-zu-Video Arbeitsabläufe.

4. Intelligenteres Geschichtenerzählen und Steuerung mehrerer Aufnahmen

WAN 2.6 ist konzipiert für Geschichtenerzählen mit mehreren Aufnahmen, nicht nur einzelne Clips:

- Intelligente Planung mehrerer Szenen — Teilt Ihre Idee automatisch in mehrere Aufnahmen mit logischen Übergängen und stabilem Tempo auf.

- Verbessertes Befolgen der Anweisungen — Bessere Einhaltung komplexer Aufforderungen, einschließlich Kamerabewegungen, Aktionen und emotionaler Tonalität.

- Stabile Bewegung und Physik — Natürliche Kamerabewegungen und konsistente Motivbewegungen, geeignet für „KI-Filme“ und realistische Kurzfilme.

Für CreatorInnen bedeutet das, dass ihr eine Szene mit mehreren Beats beschreiben könnt (Setup → Action → Payoff) und lasst Wan 2.6 generiert ein kohärentes 15-Sekunden-Video mit integrierter Erzählstruktur.

So verwenden Sie WAN 2.6 in Akool

Weil Akool integriert hat WAN 2,6 direkt in das KI-Videostudio, Sie können dieses erweiterte KI-Videomodell durch einen einfachen, geführten Arbeitsablauf.

Hier ist ein klarer schrittweiser Prozess:

Schritt 1 — Wählen Sie WAN 2.6 in Akool

- Loggen Sie sich in Ihr ein Ein Kool AI-Video Konto.

- Öffnen Sie den Arbeitsbereich zur Videogenerierung und wählen Sie WAN 2,6 aus der Modellliste. (Sie werden sehen, dass es als beschriftet ist 15-Sekunden-KI-Videogenerator mit mehreren Szenen und integriertem Audio.)

Schritt 2 — Wählen Sie Ihren Modus und Ihre Referenzen

Entscheide, wie du das Video abspielen möchtest:

- KI von Text zu Video — Beginne mit einer detaillierten Aufforderung, die Szenen, Bewegungen und Stimmung beschreibt.

- KI von Bild zu Video — Laden Sie ein Referenzbild (Charakter, Produkt, Hauptbild) hoch und fügen Sie eine Aufforderung hinzu.

- Sprach‑zu-Video‑/Audio‑gesteuert — Stellen Sie eine Audiospur (Dialog oder Sprachausgabe) für Lippensynchronisierung und Performance bereit oder lassen Sie WAN 2.6 automatische Sprachausgabe und Musik generieren.

Du kannst die vorgefertigten Vorlagen von Akool auch für gängige Szenarien wie Werbung, Kurzfilme oder Social Hooks verwenden.

Schritt 3 — Dauer, Seitenverhältnis und Stil konfigurieren

- Set Dauer (bis zu 15 Sekunden pro Clip auf Akool).

- Wählen Seitenverhältnis (16:9 Querformat, 9:16 vertikal oder 1:1 quadratisch) je nach Kanal.

- Benutze Akools Visuelle Kontrolle in Kinoqualität Optionen zur Steuerung von Beleuchtung, Farbgrad und Komposition.

Dieser Schritt richtet WAN 2.6s aus KI-Videogenerierung mit Ihrem Vertriebsplan.

Schritt 4 — Generieren, Überprüfen und Iterieren

- Klicken Sie Generieren um Ihren ersten WAN 2.6-Clip zu erstellen.

- Achten Sie auf den Erzählfluss, die Konsistenz des Themas und die Audiosynchronisierung.

- Verfeinern Sie Ihre Eingabeaufforderung, Referenzen oder Einstellungen und regenerieren Sie sie dann, bis sie Ihrer kreativen Absicht entsprechen.

Da WAN 2.6 für schnelle, filmische Renderings optimiert ist, sind die Wiederholungsschleifen kurz und praktisch für echte Produktionspläne.

Schritt 5 — Exportieren und Veröffentlichen

Sobald du mit dem Ergebnis zufrieden bist:

- Exportieren Sie das Video in dem Format und der Auflösung, die Sie benötigen (1080p wird für die meisten Plattformen empfohlen).

- Verwenden Sie es in bezahlten Anzeigen, Reels/TikToks/Kurzfilmen, Trailern, Landingpages oder Präsentationen.

Das Ökosystem von Akool macht es einfach, mehrere WAN 2.6-Generationen für verschiedene Kampagnen und Kanäle zu verwalten.

Fazit

WAN 2,6 ist ein großer Sprung für KI-Videogenerierung: 15-Sekunden-Clips mit mehreren Szenen, natives Audio und KI-Musik, referenzgesteuert Text zu Video und Bild-zu-Videound intelligentere narrative Steuerung — alles in einem einzigen multimodalen System KI-Videomodell.

Mit seiner tiefen Integration in Ein Kool AI-Video, Sie müssen keine komplexen Tools oder APIs miteinander verbinden. Sie können WAN 2.6 aus der Modellliste auswählen, eine Aufforderung schreiben, Referenzen hinzufügen und innerhalb weniger Minuten vollständig synchronisierte Filmclips generieren — bereit für soziale Inhalte, Marketingvideos, Trailer und mehr.

Wenn du dein Kurzvideo aufwerten und mit dem neuesten KI-Storytelling mit mehreren Szenen und audiosynchronisiertem KI-Storytelling experimentieren möchtest, ist jetzt der perfekte Zeitpunkt.

Loggen Sie sich bei Akool ein und probieren Sie WAN 2.6 noch heute aus.