Einführung

Der Aufstieg von Bild-zu-Video Creation Tools verändern die Art und Weise, wie YouTuber ihre Ideen und statischen Bilder in lebensechte Videoinhalte verwandeln. Die von heute Die 5 besten KI-Videokünstler für Image to Video Unterstützen Sie Profis und Einsteiger gleichermaßen, indem Sie Animationen, Kamerabewegungen und sogar 3D-Effekte aus einem einzigen Bild automatisieren. Mit diesen Plattformen kann ein YouTuber ein einfaches Foto oder Konzept aufnehmen und ein dynamisches Video erstellen — keine Dreharbeiten oder aufwändige Bearbeitung erforderlich. In den folgenden Abschnitten werden fünf führende KI-Videokünstler vorgestellt, wobei der Schwerpunkt auf ihren Stärken bei der Übertragung von Bild zu Video, den wichtigsten Funktionen, typischen Anwendungsfällen und etwaigen Einschränkungen (wie Wasserzeichen oder Cliplänge) liegt. Das Die 5 besten KI-Videokünstler für Image to Video im Jahr 2025 sind: Ein Kool, Start- und Landebahn, Kling AI,Luma AI und Pika Labs. Jedes Tool bietet etwas Einzigartiges: von Akools 4K-Qualität und der kostenlosen Testversion über die generativen Modelle von Runway, Klings Realismus, Lumas 3D-Tiefe bis hin zu Pikas Cartoon-Kreativität. Tauchen wir ein in die Die 5 besten KI-Videokünstler für Image to Video und sehen Sie, wie sie die Videoerstellung für alle vereinfachen.

1. Akool — Beste All-in-One-KI-Bild-zu-Video-Plattform mit 4K-Ausgabe

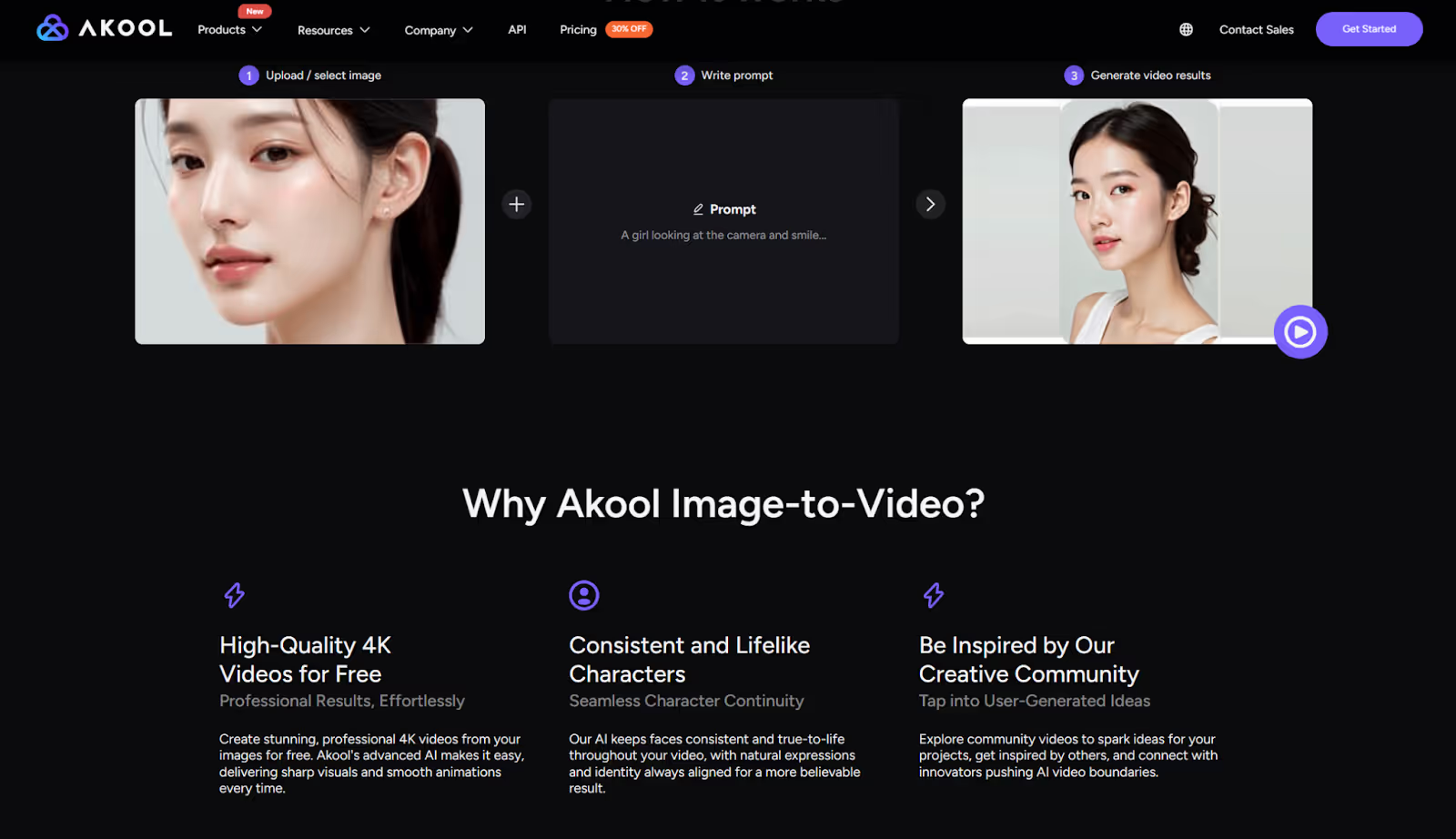

Akools Das Bild-zu-Video-Tool kann jedes statische Bild mit nur einem Klick in ein naturgetreues Video verwandeln. Diese All-in-One-KI-Plattform zeichnet sich durch ultrarealistische Ergebnisse aus und unterstützt bis zu 4K UltraHD Videogenerierung — auch im kostenlosen Tarif. In Sekundenschnelle kann Akool ein Porträt- oder Produktfoto animieren mit fotorealistische Bewegungen und Ausdrücke, dank seiner proprietären Engine zur Echtzeitgenerierung. Die Oberfläche ist zu 100% webbasiert und anfängerfreundlich, also Es ist keine Erfahrung in der Bearbeitung erforderlich um Bilder zum Leben zu erwecken.

Die wichtigsten Funktionen:

- Bildanimation mit einem Klick: Generieren Sie sofort ein Video aus einem beliebigen Bild. Laden Sie ein Standbild hoch und Akool erstellt automatisch einen kurzen Clip mit Bewegung — zum Beispiel, der das Gesicht einer Person zum Blinken, Lächeln oder Sprechen bringt. Keine manuelle Animation erforderlich.

- Voreingestellte Bewegungen und Ausdrücke: Wählen Sie aus voreingestellten Animationsstilen (wie sprechender Kopf, subtile Gesten, emotionale Ausdrücke), um Ihrem Bild schnell realistische Bewegungen zu verleihen. Sie können auch Gesichtsausdrücke, Kamerawinkel oder Lippensynchronisationsdialoge anpassen, um ein wirklich personalisiertes Ergebnis zu erzielen.

- Hochwertige 4K-Ausgabe: Akool kann Videos rendern bis zu 4K-Auflösung, liefert scharfe Bilder und flüssige Animationen. Es ist eine der wenigen Plattformen, die professionelle 4K-Ausgabe auf einer kostenlosen Testbasis bietet. Dadurch wird sichergestellt, dass Ihre Bild-zu-Video-Inhalte scharf und detailliert aussehen und für den kommerziellen Gebrauch geeignet sind.

Anwendungsfälle: Akool ist ideal, wenn Realismus und Qualität im Mittelpunkt stehen. YouTuber in den sozialen Medien verwenden es, um Portraits zu machen sprechen oder singen — zum Beispiel das Animieren eines Selfies oder einer Charaktergrafik, um eine Botschaft oder einen Witz zu vermitteln. Marketingteams verwandeln Produktbilder oder Maskottchen in schnelle Werbevideos (stellen Sie sich ein Produktfoto vor, das plötzlich rotiert und seine Merkmale beschreibt). Pädagogen haben sogar historische Fotos oder Präsentationsgrafiken mit subtilen Bewegungen zum Leben erweckt, um das Interesse der Zuschauer zu wecken. Kurz gesagt, die All-in-One-Plattform von Akool bewältigt alles, was von einem sprechenden Kopf aus zu hören ist virtueller Avatar zu einer bewegenden Produktdemo, ohne dass Sie ein Kamerateam oder Animationskenntnisse benötigen. Die kostenlose Testversion (kein Wasserzeichen) und die integrierten Tools (einschließlich Text-to-Speech für Voiceover) machen es zur ersten Wahl für alle, die ein komplettes Video aus einem einzigen Bild erstellen möchten.

2. Runway — Der kreativste Bild-zu-Video-Generator für Künstler

Runway ist eine hochmoderne KI-Medienplattform, die dafür bekannt ist, hochgradig kreatives Bild-zu-Video Generation, was es bei Künstlern und Designern beliebt macht. Es ermöglicht Ihnen, ein Eingabebild (oder auch nur ein Konzept oder eine Textaufforderung) aufzunehmen und daraus einen visuell einfallsreichen Videoclip zu generieren. Die generativen KI-Modelle von Runway (Gen-1, Gen-2 und höher) können Stile anwenden, Standbilder animieren oder sogar ganze Videos mit KI transformieren, sodass den Machern eine leistungsstarke Sandbox zum Experimentieren zur Verfügung steht. Wenn Sie ein digitales Gemälde oder Foto in ein bewegliches Kunstwerk verwandeln möchten, ist Runway eines der Die 5 besten KI-Videokünstler für Image to Video in Bezug auf Kreativität und Flexibilität.

Die wichtigsten Funktionen:

- KI-Generierung von Bild zu Video: Runway kann statische Bilder direkt in animierte Sequenzen umwandeln. Sie können beispielsweise eine Illustration oder ein Foto hochladen, und das Gen-2-Modell von Runway animiert es mit sanften Bewegungen oder stilistischen Effekten, wodurch es quasi „zum Leben erweckt“ wird. Das geht über einfache Schwenken/Zoomen hinaus — die KI kann erzwingen Sie kreative Stile oder Bewegungen Das Ausgabevideo fühlt sich also wie ein neues Stück visueller Kunst an, das vom Originalbild abgeleitet wurde.

- Fortgeschrittene Bearbeitungswerkzeuge: Runway bietet nicht nur reine Generierung, sondern auch einen integrierten KI-Videoeditor. Es bietet Funktionen wie automatische Hintergrundentfernung, Objektmaskierung und Szenenerkennung. Ersteller können Hintergründe nahtlos austauschen, KI-generierte Effekte hinzufügen oder Clips zusammenfügen. Das heißt, nachdem Sie ein Video aus Ihrem Bild generiert haben, können Sie es auf derselben Plattform optimieren — z. B. Filter anwenden, Farben anpassen oder zusätzliche Bilder hinzufügen — alles mit KI-Unterstützung.

- Mehrere generative Modelle: Die Plattform von Runway beherbergt verschiedene Modelle für unterschiedliche Bedürfnisse. Gen-1 ermöglicht von Video zu Video Transformationen (Stilisieren von vorhandenem Filmmaterial mithilfe eines Bilds oder einer Eingabeaufforderung), Gen-2-Handles Text/Bild-zu-Video Generation und neuere Modelle erweitern ständig die Funktionen. Bei diesem Ansatz mit mehreren Modellen können Benutzer experimentieren: Sie könnten ein Basisvideo aus einem Bild generieren und dann ein anderes Modell verwenden, um einen filmischen Filter anzuwenden oder ihn zu erweitern. Die Flexibilität unterstützt jeden, von Gelegenheitsbenutzern bis hin zu ML-Entwicklern, die benutzerdefinierte Workflows erstellen.

Anwendungsfälle: Runway wird häufig von digitalen Künstlern, Filmemachern und Social-Media-Machern verwendet, die möchten surreale oder stilistische Videos. Zum Beispiel kann ein Künstler ein statisches digitales Gemälde nehmen und Runway es mit driftenden Kamerabewegungen und wechselndem Licht animieren lassen, was zu einem fesselnden Kurzkunstfilm führt. YouTuber in sozialen Netzwerken könnten Runway verwenden, um ein Meme-Bild in einen lustigen animierten Clip mit Texteingaben zu verwandeln. Filmemacher und Videoproduzenten erstellen Prototypen von Szenen, indem sie Konzeptgrafiken oder Storyboards als Eingabebilder bereitstellen. Runway kann bewegte Vorschauen erstellen, wie eine Szene aussehen könnte. Das Tool eignet sich hervorragend für kurze Inhalte (wenige Sekunden bis zehn Sekunden), bei denen Kreativität das Ziel ist: Musikvideos, experimentelle Grafiken, TikTok-Clips oder Hintergrundanimationen für Designprojekte. Es ist Bild-zu-Video Können in Kombination mit der Bearbeitung bedeutet, dass man von einer Einzelbild-Idee zu einem ausgefeilten, gemeinsam nutzbaren Video gelangen kann, das komplett in Runway läuft.

Einschränkungen: Die leistungsstarken Tools von Runway sind mit einigen Einschränkungen verbunden, insbesondere im kostenlosen Tarif. Neue Benutzer erhalten eine begrenzte Anzahl von Credits (etwa 125), was bei hohen Qualitätseinstellungen nur ein paar Sekunden der Videogenerierung entspricht. Für längere oder mehrere Generationen ist ein Abonnement oder der Kauf weiterer Credits erforderlich. Außerdem haben kostenlose Ausgaben ein kleines Wasserzeichen und eine niedrigere Auflösung. Um das Wasserzeichen zu entfernen und Full-HD oder höher zu nutzen, ist ein kostenpflichtiger Tarif erforderlich. Eine weitere Einschränkung ist die Ausgabelänge — in der Vergangenheit waren die Gen-2-Clips von Runway standardmäßig etwa 4 Sekunden lang, obwohl in den letzten Updates (Gen-3/Gen-4) Möglichkeiten eingeführt wurden, diese Länge durch Zusammenfügen von Szenen zu erweitern. Dennoch steht das Generieren sehr langer Videos nicht im Mittelpunkt von Runway (du würdest längere Videos erstellen, indem du kürzere, KI-generierte Segmente zusammenschneidest). Und schließlich können die Ergebnisse von Runway, wie bei vielen generativen Modellen, gut oder schlecht ausfallen: Die Qualität der Animation hängt vom Eingabebild und der Aufforderung ab. Stark abstrakte Eingabeaufforderungen oder Bilder können zu inkonsistenten Ergebnissen führen, sodass in der Regel einige Wiederholungen erforderlich sind, um das beste Ergebnis zu erzielen. Trotz dieser Einschränkungen bleibt Runway einer der Die 5 besten KI-Videokünstler für Image to Video wenn es um künstlerisches Potenzial und innovative Funktionen geht.

3. Kling AI — Kurzclips aus Bildaufforderungen mit höchster Genauigkeit

Kling AI ist ein fortschrittlicher Videogenerator, der dafür bekannt ist, einige der meisten zu produzieren realistisch und originalgetreu Bisherige KI-Videos. Es wurde von Kuaishou (einem großen Technologieunternehmen in China) entwickelt und trat als Konkurrent zu Modellen wie Sora von OpenAI auf. Er beeindruckte die Entwickler mit dem Fotorealismus seiner Ergebnisse. Kling kann kurze Videoclips aus Text- oder Bildanweisungen erstellen und eignet sich hervorragend, wenn Sie ein Ergebnis erzielen möchten, das wie echtes Filmmaterial aussieht. Tatsächlich waren frühe Demos so lebensecht, dass einige Zuschauer dachten, es handele sich um echte Videos. Wenn erstklassige visuelle Qualität Ihre Priorität ist, gehört Kling AI zu den Die 5 besten KI-Videokünstler für Image to Video.

Die wichtigsten Funktionen:

- Fotorealistische Generierung: Kling verwendet eine ausgeklügelte KI-Architektur (ein auf 3D-VAE+-Transformatoren basierender Ansatz), um sicherzustellen, dass die Ergebnisse der Physik entsprechen und die Details beibehalten werden. Aus einem einzelnen Bild einer Person oder Szene kann es ein Video mit natürlich wirkenden Bewegungen, Ausdrücken und gleichbleibender Beleuchtung rekonstruieren. Wie originalgetreu es ist, belegen die Benchmark-Siege — Kling 1.6 Pro rangierte im März 2025 weltweit auf Platz #1 in Sachen Bild-zu-Videoqualität.

- 1080p-Auflösung und 30-fps-Ausgabe: Während sich viele KI-Videotools an niedrigere Auflösungen halten, generiert Kling Clips in volle HD 1080p mit bis zu 30 Bildern pro Sekunde. Die Ergebnisse sind glatt und detailliert — beispielsweise das Fell eines sich bewegenden Tieres oder Reflexionen im Wasser werden deutlich wiedergegeben. (Berichten zufolge wird die 4K-Ausgabe für zukünftige Versionen getestet.) Aufgrund dieser hohen Auflösung eignen sich die Kurzvideos von Kling für professionelle Inhalte oder die Integration in qualitativ hochwertigere Produktionen.

- Erweiterte Bewegungssteuerung: Für Bild-zu-Video-Aufgaben bietet Kling einzigartige Steuerfunktionen, mit denen Sie die Bewegung individuell anpassen können. Benutzer können eine angeben Startrahmen und Endrahmen (d. h. gib zwei Bilder an) und Kling animiert einen nahtlosen Übergang. Es gibt auch eine „Bewegungsbürste“ Tool — Sie können einen Pfad auf Ihr Bild zeichnen und ein Objekt diesem Pfad im Video folgen lassen. Mit diesen Funktionen kannst du die KI steuern, was zu präziseren Animationen führt (z. B. dafür, dass ein Auto auf einem Foto in eine bestimmte Richtung fährt oder ein Charakter eine gewählte Route entlang läuft).

Anwendungsfälle: Kling AI eignet sich am besten für YouTuber, die ultrarealistische Kurzvideos benötigen, z. B. für VFX-Künstler, Filmemacher oder Werbetreibende, die Prototypen von Konzepten entwickeln. Ein Filmemacher könnte zum Beispiel eine Datei füttern Bild einer Konzeptszene und holen Sie sich ein 5-Sekunden-Video mit subtiler Kamerabewegung und realistischer Atmosphäre zurück, um zu beurteilen, wie es auf dem Film aussehen könnte. Werbetreibende könnten ein Bild eines Produkts verwenden und Kling eine filmische Drehung oder Umgebung um das Produkt herum generieren lassen, sodass ein schneller Produktclip ohne Dreharbeiten produziert wird. Die Macher der sozialen Medien haben Kling auch verwendet, um aufsehenerregende Clips zu erstellen (ein berühmtes Beispiel war Panda spielt Gitarre Ein mit Kling generiertes Video, das wegen seines Realismus viral wurde (【42†】). Da Kling fantasievolle Aufforderungen mit physischer Genauigkeit interpretieren kann, ist es beliebt für Fantasy- oder Science-Fiction-Visuals — z. B. um die Konzeptkunst einer Kreatur oder Landschaft in eine bewegte Szene zu verwandeln, die sich wie aus einem Film anfühlt. Im Grunde genommen ist Kling die erste Wahl, wenn Sie ein kurzes Video benötigen, das mit echtem Filmmaterial verwechselt werden könnte.

Einschränkungen: Als Spitzenmodell hat Kling AI einige Vorbehalte. Erstens war der Zugriff zunächst eingeschränkt — es wurde über eine chinesische App gestartet und erforderte eine chinesische Telefonnummer, obwohl bis 2025 eine internationale Webversion (Kling 2.0) verfügbar ist. Neue Nutzer sehen sich immer noch mit einer Lernkurve und Warteliste; Die Benutzeroberfläche wurde zwar verbessert, ist aber aufgrund vieler Optionen und gelegentlich chinesischer Sprachelemente möglicherweise nicht so einfach wie bei anderen. Es gibt auch Einschränkungen für die Dauer — derzeit erreicht jede Generation ihr Maximum 10 Sekunden des Videos. Um längere Inhalte zu generieren, müssen die Clips extern zusammengefügt werden. Das kostenlose Kontingent von Kling ist großzügig, was die Qualität angeht, aber begrenzt in der Geschwindigkeit: Nutzer der kostenlosen Version erhalten ~66 Credits pro Tag, wodurch möglicherweise nur ein Teil eines Full-HD-Videos produziert wird (komplette Clips von 5 bis 10 Sekunden erfordern oft Hunderte von Credits). Kostenlose Generationen laufen ebenfalls langsam (manchmal stehen sie stundenlang in der Warteschlange). Was die Leistung angeht, ist Kling zwar in der Regel ausgezeichnet, kann aber mit extrem komplexen Eingabeaufforderungen zu kämpfen haben, die präzise Interaktionen oder viele Charaktere beinhalten — z. B. die Aufrechterhaltung der Konsistenz einer Figur über mehrere Clips hinweg oder die Handhabung schneller Aktionen mit perfekter Genauigkeit (in komplexen Szenen können kleinere physikalische Störungen auftreten). Schließlich bedeutet der hohe Rechenaufwand, dass die Nutzer die Nutzung des Guthabens sorgfältig planen müssen (ein einziger qualitativ hochwertiger Clip kann bei kostenpflichtigen Tarifen den größten Teil des monatlichen Kontingents verbrauchen). Zusammenfassend lässt sich sagen, dass Kling ein Kraftpaket für realistischen Bild-zu-Video-Realismus ist. Es eignet sich jedoch am besten für kurze, geplante Clips und für Nutzer, die bereit sind, den Ressourcenbedarf zu bewältigen.

4. Luma AI — Erstklassige Engine zur Generierung von 3D-Bildern in Videos

Luma AI ist eine innovative Plattform, die sich auf die Umwandlung von Bildern (oder Bildgruppen) in Videos mit einem 3D-Optik und Haptik. Wenn Sie diese Kinoanimationen gesehen haben, bei denen ein Standbild Tiefe zu haben scheint und die Kamera sich durch das Bild bewegt (oft als „Parallaxeneffekt“ bezeichnet), automatisiert Luma diesen Vorgang mithilfe von KI. Was macht Luma zu einem der Die 5 besten KI-Videokünstler für Image to Video ist seine Grundlage in der 3D-Rekonstruktionstechnologie: Es kann flache Bilder aufnehmen und Videos generieren, die eine dreidimensionale Umgebung simulieren, komplett mit realistischen Perspektivverschiebungen und Kamerabewegungen. Für YouTuber, die Produkte, Landschaften oder jede Szene mit einem immersiven 3D-Twist präsentieren möchten, ist Luma AI die erste Wahl.

Die wichtigsten Funktionen:

- KI-gestützte Bildanimation: Luma verwendet KI zum Hinzufügen natürliche Bewegungseffekte zu deinen Standbildern. Bei minimaler Eingabe kann das System die Kamera sanft schwenken, zoomen oder das Objekt umkreisen, sodass der Betrachter das Gefühl hat, sich in der Szene zu bewegen. Die Übergänge sind fließend und filmisch — zum Beispiel kann aus einem einfachen Foto einer Straße in einer Stadt ein kurzes Video werden, in dem die Kamera nach vorne gleitet, als ob sie das Foto betreten würde.

- 3D-Tiefe und Perspektive: Ein herausragendes Merkmal von Luma ist die Fähigkeit, eine zu erstellen Illusion von Tiefe aus 2D-Bildern. Die KI analysiert das Bild, um sich einer 3D-Struktur anzunähern: Was ist Vordergrund, was ist Hintergrund. Beim Animieren passt sie dann die Perspektive entsprechend an. Das bedeutet, dass Sie Videos erhalten, in denen sich beispielsweise ein Baum im Vordergrund und Berge im Hintergrund relativ zueinander verschieben, wenn sich die Kamera bewegt — was einen 3D-Parallaxeneffekt erzeugt. Wenn du mehrere Fotos von einem Objekt oder einer Szene (aus verschiedenen Blickwinkeln) zur Verfügung stellst, kann Luma sogar ein genaueres 3D-Modell erstellen und ein Video generieren, das das Objekt umgibt, fast wie eine virtuelle Kamera in einem echten 3D-Raum.

- Hochwertige und optionale Interaktivität: Die Ausgabequalität von Luma ist hoch und produziert oft 1080p-Videos mit realistischen Texturen und Beleuchtung. Es bietet auch eine API und Integration für Entwickler oder Unternehmen. Insbesondere Luma begann als NerF-App (Neural Radiance Field) zur Erfassung realer Objekte in 3D. Dieses Erbe bedeutet, dass fortgeschrittene Benutzer interaktive 3D-Ansichten erstellen oder Lumas Bild-zu-Video-Generierung in Apps integrieren können (z. B. eine Immobilien-App, die Immobilienfotos in eine 3D-Videotour umwandelt). Für die meisten YouTuber ist es dank der Web- und mobilen App-Oberfläche einfach: Laden Sie Bilder hoch, wählen Sie Ihre Bewegung oder Ihren Effekt aus und generieren Sie das Video.

Anwendungsfälle: Luma AI eignet sich perfekt für Szenarien, in denen Sie statische Grafiken durch Hinzufügen von Tiefe ansprechender gestalten möchten. Fotografen verwenden Luma, um Standbilder zu animieren — zum Beispiel, um ein Porträt aufzunehmen und ein subtiles Push-In-Video zu erstellen, das dem Foto Dramatik verleiht. Produktpräsentation ist ein großer Anwendungsfall: E-Commerce-Verkäufer können Produktbilder eingeben und Luma ein 360°-Rotationsvideo oder einen umfassenden Zoom erstellen lassen, der die Form des Produkts hervorhebt. Im Immobilien- oder Architekturbereich kann ein einzelnes Foto eines Raums in ein kurzes Video umgewandelt werden, das potenziellen Betrachtern ein Gefühl von Raum vermittelt. Inhaltsersteller und Vermarkter lieben es, Luma für Beiträge in sozialen Netzwerken zu verwenden und aus einer flachen Infografik oder einem Flyer eine bewegte 3D-Story zu machen (Text oder Logos können in einem Bild platziert und dann mit Tiefe animiert werden). Sogar Spieledesigner oder Konzeptkünstler verwenden Luma, um Szenen zu prototypisieren — zum Beispiel, um einen schnellen Überblick über eine Konzeptkunstlandschaft zu erstellen, um sie besser zu visualisieren. Im Wesentlichen Luma AI verwischt die Grenze zwischen 2D und 3D, das immersives Geschichtenerzählen anhand gewöhnlicher Bilder ermöglicht.

Einschränkungen: Luma ist zwar leistungsstark, Benutzer sollten sich jedoch einiger Einschränkungen bewusst sein. Das kostenlose Abo auf Luma's Dream Machine (Stand Mitte 2025) ist etwas eingeschränkt: Es erlaubt nur bildbasierte Generierungen (kostenlos gibt es keine Text-zu-Video-Version) und die Ausgänge sind mit einem Wasserzeichen auf 720p begrenzt. Um Full HD 1080p und ohne Wasserzeichen nutzen zu können, ist ein kostenpflichtiges Abonnement erforderlich. Was die Eingabe angeht: Wenn Sie nur ein einziges Bild angeben, wird der Umfang des 3D-Effekts von der KI intelligent erraten — bei realistischen Szenen ist das subtil. Extrem komplexe Szenen oder Bilder mit unklarer Tiefe werden möglicherweise nicht perfekt animiert (bei starken Bewegungen der Kamera kann es zu Verzerrungen an den Rändern kommen). Um ein sehr ausgeprägtes 3D-Ergebnis zu erzielen, benötigst du oft mehrere Bilder oder eine kurze Eingabe für einen Videoclip (den die Luma-App aufnehmen und in ein 3D-Modell umwandeln kann). Eine weitere Einschränkung ist die Cliplänge: Die Bild-zu-Videoclips von Luma sind in der Regel einige Sekunden lang (ideal für einen schnellen Orbit oder Pan). Wenn du eine längere Sequenz benötigst, würdest du mehrere Clips generieren oder ihr Keyframe-Tool in der App verwenden, um Züge zusammenzusetzen, was mehr Aufwand erfordert. Und da Luma eine umfangreiche KI-Verarbeitung verwendet (vor allem, wenn 3D von Grund auf neu konstruiert wird), kann die Generierung je nach Komplexität einige Zeit in Anspruch nehmen — nicht so langsam wie manche, aber bei detaillierten Szenen rechnen Sie mit ein oder zwei Minuten. Trotzdem ist Luma AI nach wie vor einzigartig positioniert, wenn es darum geht, bildbasierten Videos ein 3D-Flair zu verleihen, und festigt so seinen Platz in der Die 5 besten KI-Videokünstler für Image to Video.

5. Pika Labs — Bester KI-Animator von Bild zu Video im Anime-Stil

Pika Labs ist eine Plattform zur KI-Videogenerierung, die sich durch ihre Animationen im Anime-Stil und stilisierte Animationen. Es ermöglicht Benutzern, kurze Videos entweder aus Text- oder Bildaufforderungen zu erstellen. Eine besondere Stärke besteht darin, illustrierte oder fantasievolle Bilder in animierte Clips umzuwandeln. Wenn Sie ein Schöpfer sind, der Anime, Cartoons oder kreative visuelle Effekte liebt, sticht Pika Labs unter den hervor Die 5 besten KI-Videokünstler für Image to Video für die Produktion dieser Art von lebendigen, künstlerischen Videos. Die Plattform wurde ursprünglich über einen Discord-Bot gestartet und hat seitdem eine Weboberfläche entwickelt, die es einfach macht, mit nur einer Aufforderung von einem statischen Bild oder einer Idee zu einem dynamischen Video zu wechseln.

Die wichtigsten Funktionen:

- Generierung von Text und Bild zu Video: Pika Labs unterstützt beide Text-zu-Video und Bild-zu-Video fordert auf. Du kannst einfach eine Szene beschreiben oder ein Bild hochladen und Pika einen kurzen animierten Videoclip erstellen lassen. Die Ausgaben dauern in der Regel einige Sekunden (etwa 1—5 Sekunden), sind aber voller Details. Wenn Sie beispielsweise ein Bild einer Fantasy-Figur eingeben, kann dies zu einer kurzen Animation führen, in der diese Figur blinkt und sich der Hintergrund bewegt, als ob es sich um eine Szene aus einem Anime-Film handeln würde. Diese Flexibilität bei der doppelten Eingabe bedeutet, dass Sie mit einer leeren Idee beginnen oder ein vorhandenes Bild verbessern können.

- Mehrere Stile und Effekte („Pikeffects“): Pika Labs bietet einzigartige kreative Effekte wie“Stoß drauf“ und“Zerreiß es“, die Videos stilisierte Transformationen hinzufügen. Diese sind Teil einer Reihe von „Pikaffects“ und anderen Funktionen (Pikadditionen, Pikaswaps usw.), die es ermöglichen, Charaktere auszutauschen oder Elemente über Bildanweisungen zum Video hinzuzufügen. Im Wesentlichen kannst du nicht nur ein Bild animieren, sondern auch mehrere KI-Elemente zusammensetzen. Das Tool ist besonders bekannt für Anime- und Cartoon-Stile — viele Entwickler verwenden Pika, um Anime-Szenen oder spielähnliche Filmaufnahmen zu erstellen, da die Engine dazu neigt, eine gezeichnete oder CGI-Ästhetik gut beizubehalten. Das Seitenverhältnis und die Dauer können ebenfalls angepasst werden (verschiedene gängige Bildverhältnisse wie 16:9, 9:16, 1:1 usw. werden unterstützt, und Sie können bei neuen Updates eine Videolänge von bis zu ~5 Sekunden oder etwas mehr wählen).

- Schnell und zugänglich: Pika Labs legt Wert auf schnelle Generierung und iterative Kreativität. Es gibt Vorlagen und Voreinstellungen für gängige Aufgaben, und die Benutzeroberfläche (einschließlich der Discord-Bot-Befehle) ermöglicht das Hinzufügen von Parametern wie Kamerabewegung, FPS oder Lenkstärke für eine erweiterte Steuerung. Für die meisten Benutzer ist es jedoch einfach: Gib deine Eingabeaufforderung/dein Bild ein, wähle optional einen Effekt aus (wie „Regen hinzufügen“ oder „Anime-Filter“) und generiere ihn. Der kostenloser Basisplan enthält eine Reihe von Videocredits (ca. 80—150 pro Monat, Stand 2025), was ausreicht, um viele Animationen auszuprobieren. Pikas Community ist auch ein Vorteil — da sie auf Discord begann, gibt es eine Fülle von gemeinsamen Aufforderungen und Beispielen, von denen man lernen kann, was die kreative Inspiration antreibt.

Anwendungsfälle: Pika Labs wird von Inhaltserstellern geliebt, die produzieren möchten stilisierte animierte Inhalte schnell. Stellen Sie sich einen Comiczeichner vor, der ein Panel seines Comics animieren möchte — Pika kann das gezeichnete Bild aufnehmen und ein kurzes Video erstellen, in dem die Kamera heranzoomt und sich die Figur leicht bewegt, was dem Kunstwerk einen dramatischen Effekt verleiht. Es wird auch zum Erstellen verwendet Musikvideos oder GIFs im Anime-Stil: Benutzer könnten beispielsweise eine Reihe von 3-Sekunden-Anime-Landschaftsclips erstellen, die ein Lied begleiten. Social-Media-Vermarkter haben Pika verwendet, um auffällige animierte Beiträge zu verfassen (stellen Sie sich ein statisches Maskottchen-Logo vor, das über Pika mit Funkeln oder Bewegungen animiert wird). Ein weiterer Anwendungsfall ist das Prototyping für Animationen: Wenn Sie ein Charakterdesign haben, kann Pika Labs es mit einer einfachen Aktion (wie Winken oder Drehen) animieren, um zu visualisieren, wie es in Bewegung aussehen könnte. Weil Pika unterstützt Hinzufügen von Objekten zu echten Videos (Pikaswap), Videoeditoren verwenden es, um mit visuellen Effekten zu experimentieren — z. B. um ein echtes Video aufzunehmen und ein Objekt oder eine Person durch ein Bild von etwas anderem zu ersetzen. Von rein kreativen Animationen bis hin zu praktischen Effekten bietet Pika Labs ein breites Spektrum an, mit einer Tendenz zu fantasievollen, Spaß Bildmaterial.

Einschränkungen: Pika Labs konzentriert sich von Natur aus auf kurze Clips — normalerweise 5 Sekunden oder weniger pro Generation für die meisten Modelle (obwohl neuere Versionen dies in einigen Fällen auf etwa 10 Sekunden verlängert haben). Es ist also nicht dafür gedacht, eine Animation in voller Länge auf einmal zu erstellen. Sie müssten die Ausgaben aneinanderreihen, wenn Sie eine längere Geschichte haben möchten. Die Ausgabeauflösung verbessert sich zwar, ist aber im Allgemeinen für das Teilen im Internet und in sozialen Netzwerken optimiert (bei Modellen höherer Stufen oft um 720p oder 1080p). Extrem hoher Realismus ist nicht die Domäne von Pika — ihre Stärke sind stilisierte Inhalte. Wenn Sie also versuchen, einen Live-Action-Look zu erzielen, erhalten Sie möglicherweise nicht die gleiche Wiedergabetreue wie ein Tool wie Kling. Es kann zu Flackern- oder Konsistenzproblemen bei den Ausgaben kommen (häufig bei der KI-Videogenerierung) — zum Beispiel kann sich das Outfit einer Anime-Figur zwischen den einzelnen Frames leicht ändern. Pika mildert dies mit Funktionen zur „Charakterkonsistenz“ ab (z. B. die Verwendung desselben Seeds oder neuer Funktionen wie Pikaframes für Keyframe-Szenen), aber es entwickelt sich immer noch weiter. Eine weitere Einschränkung ist die Kreditsystem: Es gibt zwar eine kostenlose Stufe, aber komplexe Funktionen oder neuere Modelle (z. B. Pika 2.1- oder 2.2-Modelle) verbrauchen mehr Credits (einige erweiterte Effekte können 60 oder mehr Credits pro Video kosten). Das bedeutet, dass kostenlose Nutzer möglicherweise nur eine Handvoll Videos generieren, bevor sie auf den nächsten Monat warten oder ein Upgrade durchführen müssen. Da Pika Labs ursprünglich auf Discord war, könnte es sein, dass neue Benutzer auf der Webplattform die Fülle an Funktionen und seltsam benannten Effekten zunächst etwas überwältigend finden. Es ist ratsam, mit einfachen Eingabeaufforderungen zu beginnen und nach und nach die erweiterten Optionen auszuprobieren. Trotzdem hält Pika Labs seinen Platz in unserem Die 5 besten KI-Videokünstler für Image to Video weil es ein Maß an kreativer Animation freischaltet, das nur wenige andere bieten — besonders für Fans von Anime und lebendigen visuellen Stilen.

Fazit

Zusammenfassend lässt sich sagen, dass KI-Tools von Bild zu Video erhebliche vereinfachte den Videoerstellungsprozess. Was früher erfahrene Animatoren oder Videofilmer erforderte, kann jetzt von jedem mit einer Idee und einem einzigen Bild erreicht werden. Unsere Erkundung der Die 5 besten KI-Videokünstler für Image to Video hebt hervor, dass jede Plattform ihre Nische hat: Ein Kool bietet ein unvergleichliches All-in-One-Erlebnis mit realistischer Animation, 4K-Ausgabe und sogar Audiointegration — so ist es wirklich möglich, ein vollständiges Video aus einem Foto zu erstellen.

Bei der Auswahl zwischen Die 5 besten KI-Videokünstler für Image to Video, denke über dein Ziel nach. Wenn Sie höchste Qualität und Auflösung mit einem unkomplizierten Arbeitsablauf priorisieren, Ein Kool ist ein ausgezeichneter erster Stopp. Die Testversion ist kostenlos. Sie können also ein Bild hochladen und sofort Ergebnisse in 4K-Qualität sehen — eine Funktion, die Konkurrenten häufig kostenpflichtigen Tarifen vorbehalten. Akools All-in-One-Konzept (Bild und Stimme) bedeutet, dass Sie aus einem Foto auf einer Plattform buchstäblich eine sprechende Videobotschaft generieren können, was ein überzeugender Vorteil ist. Wir empfehlen Ihnen dringend erkunde zuerst Akool — Nutzen Sie die kostenlose Testversion und experimentieren Sie damit, Ihre eigenen Fotos oder Ideen zum Leben zu erwecken. Egal, ob es sich um ein professionelles Projekt oder ein persönliches kreatives Experiment handelt, Akool kann mit minimalem Aufwand professionelle, lebensechte Videos liefern. Von dort aus können Sie auch die anderen auf unserer Liste für speziellere Bedürfnisse ausprobieren (kreatives Styling mit Runway, Ultrarealismus mit Kling usw.). Das Fazit ist, dass KI-Tools von Bild zu Video den Entwicklern mehr Möglichkeiten bieten als je zuvor. Also mach weiter — wähle deinen Favoriten KI-Videoersteller, laden Sie das Bild hoch und sehen Sie zu, wie Ihre visuellen Ideen in die Realität umgesetzt werden. Ihr Publikum wird erstaunt sein, wie schnell Ihre statischen Inhalte zu dynamischen Videos werden, und Sie werden in der neuen Ära der KI-gesteuerten Kreativität einen Schritt voraus sein.

.avif)