Als Videoinhalte explodieren auf sozialen Plattformen und Websites, die Gewährleistung eines sicheren und qualitativ hochwertigen Seherlebnisses ist wichtiger denn je.

Aber manuell Moderation von Inhalten ist langsam, teuer und anfällig für menschliche Fehler. Hier kommt die KI-gestützte Videomoderation ins Spiel und bietet eine schnellere, skalierbare Lösung.

In diesem Artikel erklären wir, was Videomoderation ist, warum sie wichtig ist, wie KI-Tools sie effizient machen und wie sie effektiv implementiert werden kann.

Was ist Videomoderation?

Bei der Videomoderation werden Videoinhalte analysiert, um bestimmte Arten von unerwünschtem oder schädlichem Material zu erkennen und herauszufiltern, bevor sie veröffentlicht werden oder während sie live sind. Dazu gehört auch die Überprüfung auf:

- Nacktheit oder sexueller Inhalt

- Gewalt, Selbstverletzung oder Missbrauch

- Hassreden oder grafische Sprache in Audio/Untertiteln

- Unangemessene Gesten oder visuelle Symbole

- Spam, irreführende Inhalte oder unautorisiertes Branding

Bei der Moderation geht es nicht nur darum, „schlechte“ Inhalte zu entfernen, sondern auch darum, nicht konforme, markenfremde oder qualitativ minderwertige Videos zu melden, die nicht den spezifischen Standards einer Plattform oder eines Werbetreibenden entsprechen.

Es umfasst in der Regel mehrere Ebenen:

- Visuelle Analyse: Überprüfung der Frames auf Nacktheit, Waffen, anstößige Symbole usw.

- Audioanalyse: Erkennung von Obszönitäten, Hassreden oder unangemessenen Dialogen.

- Metadaten-/Textüberprüfung: Bildunterschriften, Titel und Bildschirmtext werden nach Verstößen durchsucht.

- Kontextuelles Verständnis: Feststellen, ob etwas im Kontext schädlich ist, nicht nur anhand von Schlüsselwörtern (z. B. Satire oder Hassreden).

Wie funktioniert die Videomoderation?

Die Videomoderation umfasst die Überprüfung und Verwaltung von Videoinhalten, um sicherzustellen, dass sie den Plattformrichtlinien, rechtlichen Standards und Gemeinschaftswerten entsprechen.

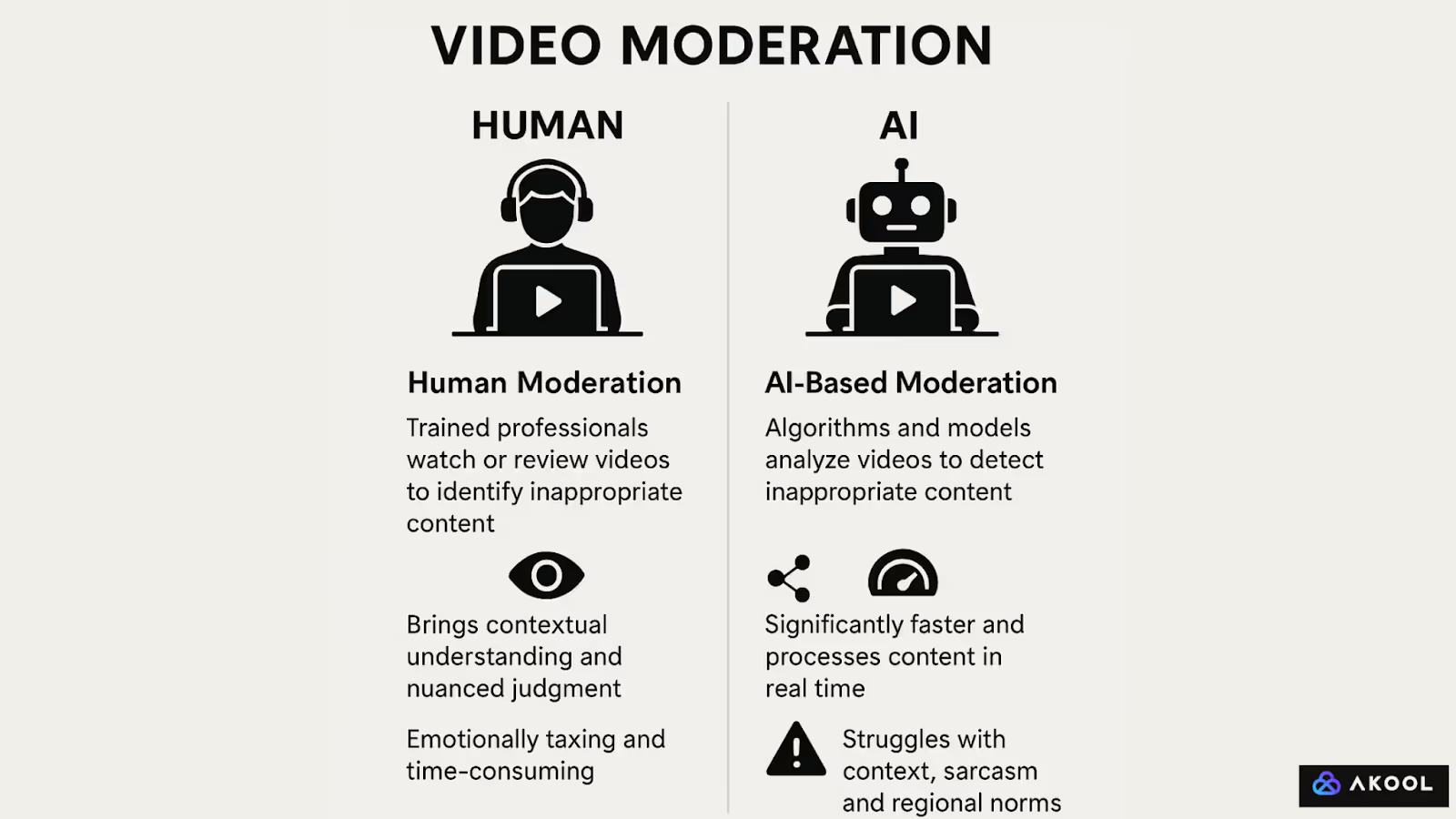

Wenn die Moderation von Menschen durchgeführt wird, beinhaltet die Moderation in der Regel geschulte Fachkräfte, die sich Videos vollständig ansehen oder markierte Abschnitte überprüfen, um festzustellen, ob sie unangemessene Inhalte wie Gewalt, Hassreden, Nacktheit oder Fehlinformationen enthalten.

Menschliche Moderatoren bringen kontextuelles Verständnis und differenziertes Urteilsvermögen mit, insbesondere in Fällen, in denen kulturelle Sensibilität oder Absicht schwer einzuschätzen sind. Diese Arbeit kann jedoch emotional anstrengend und zeitaufwändig sein.

Bei der KI-basierten Moderation werden dagegen Algorithmen und Modelle für maschinelles Lernen verwendet, um Videos automatisch zu analysieren. Diese Systeme können visuelle Elemente (z. B. Nacktheit, Waffen), akustische Hinweise (z. B. beleidigende Sprache) und sogar Text in Untertiteln oder Überlagerungen erkennen.

KI ist deutlich schneller und kann große Mengen an Inhalten in Echtzeit verarbeiten, was sie für große Plattformen wie YouTube oder TikTok unverzichtbar macht. Dennoch

KI kann mit Kontext, Sarkasmus oder regionalen Normen zu kämpfen haben, was zu falsch positiven oder negativen Ergebnissen führt. In der Praxis verwenden die meisten Plattformen einen hybriden Ansatz: KI filtert und kennzeichnet fragwürdige Inhalte, die dann bei Bedarf zur abschließenden Überprüfung an menschliche Moderatoren weitergeleitet werden. Dieses Gleichgewicht hilft dabei, die Moderation zu skalieren und gleichzeitig Genauigkeit und Fairness zu gewährleisten.

So moderieren Sie Videos mit KI

Legen Sie zunächst klare, spezifische Inhaltsrichtlinien fest, die die Werte Ihrer Community widerspiegeln.

Dokumentieren Sie genau, was akzeptabel ist und was nicht, und verwenden Sie nach Möglichkeit echte Beispiele. Moderne KI-Tools, inkl. Jarvis, Moderator von AKOOL:

Schritt 1: Laden Sie das Video hoch

Loggen Sie sich auf Ihrer Moderationsplattform ein (z. B. Akool Jarvis Moderator) und laden Sie das Video hoch, das Sie überprüfen möchten. Die Plattform unterstützt verschiedene Formate und Auflösungen.

Schritt 2: Automatisches multimodales Scannen

Nach dem Hochladen analysiert die KI automatisch:

- Visueller Inhalt (z. B. Nacktheit, Gewalt, Waffen)

- Audio (z. B. Hassreden, explizite Sprache)

- Textüberlagerungen oder Untertitel (z. B. unsichere oder schädliche Nachrichten)

Jarvis verwendet KI-Modelle, die darauf trainiert sind, den Kontext aus allen drei Modi — Video, Ton und Text — gleichzeitig zu verstehen.

Schritt 3: Berichte über Verstöße überprüfen

Nach dem Scannen kennzeichnet die Plattform alle erkannten Verstöße und weist jedem Verstoß Vertrauenswerte zu (wie sicher sich die KI in Bezug auf das Problem ist). Verstöße werden visuell markiert, sodass du schnell zum entsprechenden Abschnitt des Videos springen kannst.

Schritt 4: KI-Entscheidungen validieren oder außer Kraft setzen

Überprüfen Sie als Moderator die Ergebnisse der KI. Du kannst:

- Bestätigen gültige Verstöße

- Überschreiben falsch positive Ergebnisse (z. B. harmloser Inhalt, der fälschlicherweise als riskant identifiziert wurde)

- Eskalieren Randfälle zur Überprüfung durch Menschen, falls erforderlich

Schritt 5: Maßnahmen ergreifen

Wenden Sie auf der Grundlage Ihrer Bewertung Moderationsmaßnahmen an:

- Genehmigen

- entfernen

- Altersbeschränkung

- Zur zweiten Überprüfung senden

Schritt 6: Protokollieren und melden

Speichern oder exportieren Sie Moderationsprotokolle für Transparenz und Compliance-Nachverfolgung. Die meisten Plattformen bieten Audit-Trails und Analyse-Dashboards.

Bewährte Methoden für die Videomoderation

1. Kontextuelle Überprüfung von Metadaten und Kommentaren

Viele vergessen, dass das Video selbst nicht die einzige Quelle für schädliche Inhalte ist — Titel, Beschreibungen und Nutzerkommentare können Verstöße enthalten oder den Kontext liefern, der die Interpretation des Videos verändert.

2. Regelmäßige Umschulung von KI-Modellen

Die Moderationstools für KI müssen regelmäßig aktualisiert werden, um sich an den sich ändernden Slang, Trends und Manipulationstechniken anzupassen. Wenn dies vernachlässigt wird, führt dies zu veralteten Filtern, die neue Formen des Missbrauchs übersehen oder harmlose Inhalte kennzeichnen.